AI 世界仍在研究如何处理DALL-E 2 绘制/绘画/想象几乎任何东西的惊人实力展示……但 OpenAI 并不是唯一一个从事此类工作的人。谷歌研究院已经急于公开它一直在研究的类似模型——它声称它甚至更好。

Imagen (明白了吗?)是一个基于文本到图像扩散的生成器,它建立在大型转换器语言模型之上……好吧,让我们放慢速度,快速解压。

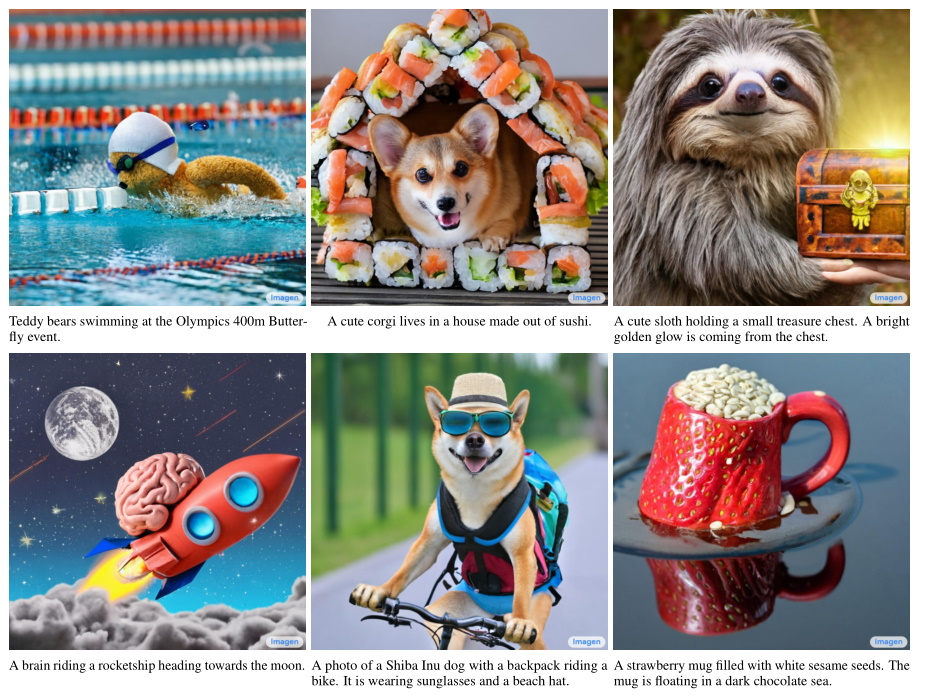

文本到图像模型接受文本输入,如“自行车上的狗”,并生成相应的图像,这已经做了多年,但最近在质量和可访问性方面出现了巨大的飞跃。

其中一部分是使用扩散技术,该技术基本上从纯噪声图像开始,然后一点一点地对其进行细化,直到模型认为它不能让它看起来更像自行车上的狗。这是对自上而下生成器的改进,在第一次猜测时可能会出错,而其他生成器很容易误入歧途。

另一部分是通过使用转换器方法的大型语言模型来提高语言理解,我不会(也不能)在这里讨论技术方面,但它和其他一些最近的进展已经导致令人信服的语言模型,例如GPT-3 等。

图片来源:谷歌研究

Imagen 首先生成一个小(64×64 像素)图像,然后对其进行两次“超分辨率”传递,使其达到 1024×1024。不过,这与普通的放大不同,因为 AI 超分辨率会以原始图像为基础创建与较小图像协调的新细节。

假设您有一只狗骑自行车,并且在第一张图像中狗的眼睛是 3 个像素。没有太多的表达空间!但在第二张图片上,它的宽度为 12 个像素。这需要的细节从何而来?好吧,人工智能知道狗的眼睛长什么样,所以它会在绘制时生成更多细节。然后当眼睛再次完成时再次发生这种情况,但在 48 像素处。但在任何时候,人工智能都不必从它的狗眼中拉出 48 个像素……比方说魔术袋。像许多艺术家一样,它从一个粗略的草图开始,在书房里填满,然后在最后的画布上真正进城。

这并非史无前例,事实上,使用 AI 模型的艺术家已经使用这种技术来创建比 AI 一次性处理的更大的作品。如果您将画布分成几块,并分别对它们进行超分辨率处理,您最终会得到更大、更复杂的细节;你甚至可以反复做。我认识的一位艺术家的一个有趣的例子:

之前发布的图像高达 24576 x 11264 像素。没有升级。事实上,我已经远远超出了@letsenhance_io的限制。

该图像就是我所说的“第三代”(双关语),它的 420 个切片是从已经重新生成一次的先前图像重新生成的。

2/10 pic.twitter.com/QG2ZcccQma

— dilkROM 故障 (@dilkROMGlitches) 2022 年 5 月 17 日

谷歌的研究人员声称 Imagen 取得了多项进展。他们说现有的文本模型可以用于文本编码部分,并且它们的质量比简单地增加视觉保真度更重要。从直觉上讲,这是有道理的,因为详细的废话图片肯定比详细说明您所要求的内容的详细图片更糟糕。

例如,在描述 Imagen 的论文中,他们将它的结果与 DALL-E 2 的“制作拿铁艺术的熊猫”进行了比较。在后者的所有图像中,都是熊猫的拿铁艺术;在 Imagen 的大部分作品中,它是一只制作艺术的熊猫。 (两者都无法渲染骑马的宇航员,在所有尝试中都显示出相反的结果。这是一项正在进行的工作。)

图片来源:谷歌研究

在谷歌的测试中,Imagen 在人类评估测试中领先,无论是准确度还是保真度。这显然是相当主观的,但即使与 DALL-E 2 的感知质量相匹配,直到今天仍被认为是领先于其他一切的巨大飞跃,令人印象深刻。我只会补充一点,虽然它非常好,但这些图像(来自任何生成器)在人们注意到它们是生成的或有严重怀疑之前,都只能经受粗略的审查。

不过,OpenAI 在几个方面领先谷歌一两步。 DALL-E 2 不仅仅是一篇研究论文,它是一个私人测试版,人们使用它,就像他们使用它的前身以及 GPT-2 和 3 一样。具有讽刺意味的是,名称中带有“开放”的公司专注于产品化其文本到图像研究,而这家利润丰厚的互联网巨头尚未尝试。

从 DALL-E 2 的研究人员所做的选择中可以清楚地看出这一点,即提前管理训练数据集并删除任何可能违反他们自己的指导方针的内容。如果尝试,该模型无法做出 NSFW 的东西。然而,谷歌的团队使用了一些已知包含不适当材料的大型数据集。在 Imagen 网站上描述“限制和社会影响”的有见地的部分中,研究人员写道:

文本到图像模型的下游应用多种多样,可能以复杂的方式影响社会。滥用的潜在风险引起了人们对负责任的代码和演示开源的担忧。目前我们决定不发布代码或公开演示。

文本到图像模型的数据需求导致研究人员严重依赖大型、大多数未经管理的网络抓取数据集。虽然这种方法近年来实现了算法的快速进步,但这种性质的数据集通常反映了社会刻板印象、压迫性观点以及与边缘化身份群体的贬损或其他有害关联。虽然我们的训练数据子集被过滤以去除噪音和不良内容,例如色情图像和有毒语言,但我们还使用了已知包含大量不当内容的 LAION-400M 数据集,包括色情图像、种族主义诽谤和有害的社会刻板印象。 Imagen 依赖于在未经管理的网络规模数据上训练的文本编码器,因此继承了大型语言模型的社会偏见和局限性。因此,Imagen 存在编码有害刻板印象和表示的风险,这指导我们决定在没有进一步保护措施的情况下不发布 Imagen 供公众使用

虽然有些人可能会对此嗤之以鼻,称谷歌担心其人工智能在政治上可能不够正确,但这是一种无情且短视的观点。人工智能模型的好坏取决于它所训练的数据,并不是每个团队都可以花费时间和精力来移除这些爬虫在组装数百万张或数十亿张图像时收集到的非常糟糕的东西——词数据集。

这种偏见是在研究过程中出现的,它揭示了系统是如何工作的,并为识别这些和其他限制提供了一个不受约束的测试场。不然我们怎么知道人工智能不能画出黑人常见的发型——任何孩子都能画的发型?或者当被要求写关于工作环境的故事时,人工智能总是让老板变成男人?在这些情况下,AI 模型可以完美运行并按设计运行——它成功地学习了在其训练的媒体中普遍存在的偏见。和人不一样!

但是,虽然忘掉系统性偏见对许多人来说是一个终生的项目,但人工智能更容易,它的创造者可以从一开始就删除导致它表现不佳的内容。也许有一天,人工智能需要以 50 年代种族主义、性别歧视专家的风格写作,但目前包含这些数据的好处很小,风险很大。

无论如何,Imagen 和其他人一样,显然仍处于实验阶段,除了严格的人工监督方式外,还没有准备好以任何方式使用。当 Google 开始着手让其功能更易于访问时,我相信我们会更多地了解它的工作原理和原因。