我将从最后开始。不,不是。

当然,我不能就此罢休。提出这个问题的原因是,有很多说法表明他们有点拖延。就连伊利亚也这么说。

感谢您阅读奇怪的循环佳能!免费订阅以接收新帖子并支持我的工作。

人工智能实验室 Safe Superintelligence (SSI) 和 OpenAI 的联合创始人 Ilya Sutskever 最近告诉路透社,这是扩大预训练规模的结果,即训练人工智能模型的阶段,使用大量未标记的数据来理解语言模式和结构- 已趋于稳定。

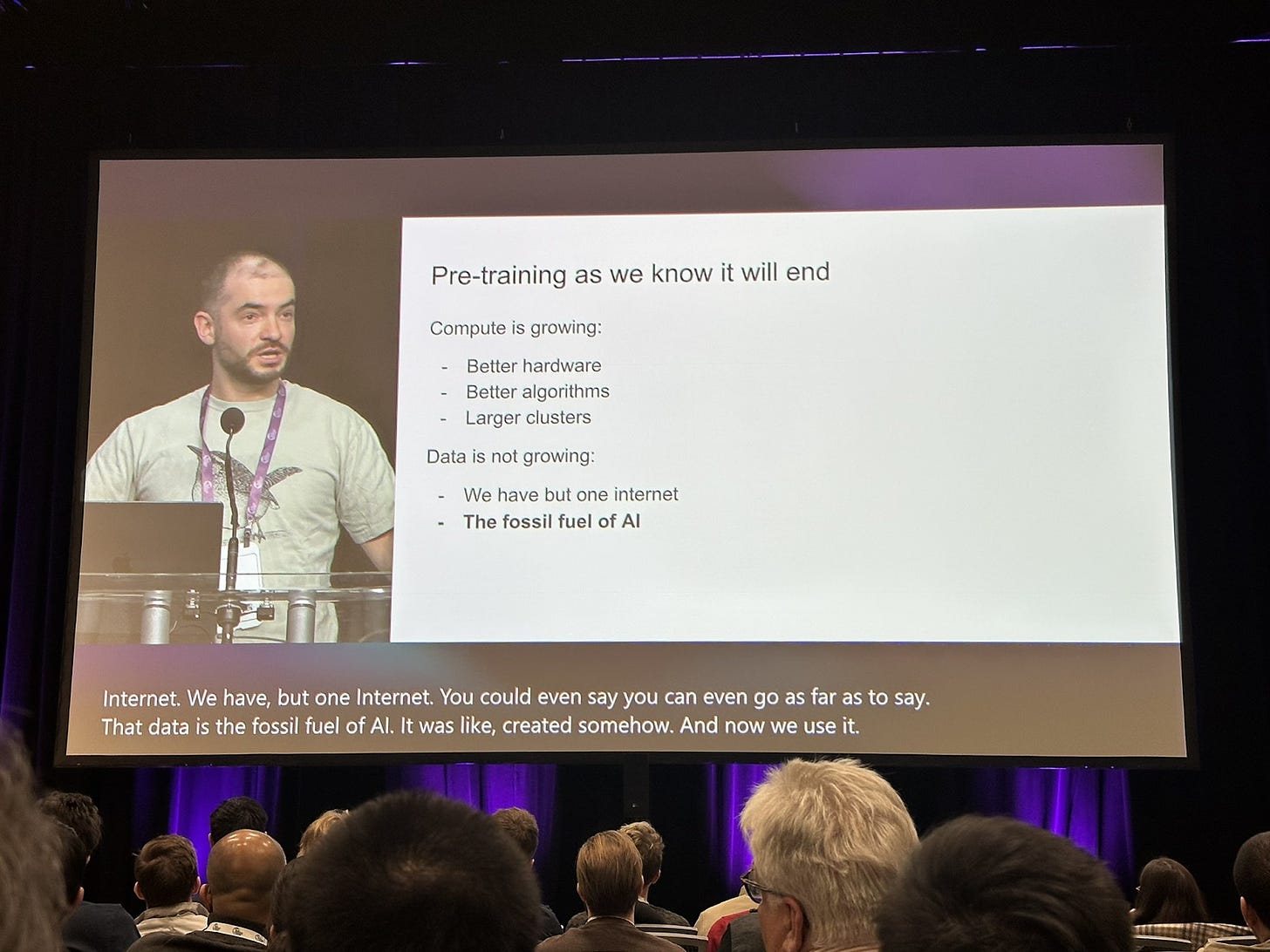

另外,正如他昨天在 Neurips 上所说:

当然,他现在是 OpenAI 的竞争对手,所以通过大肆宣传计算作为压倒性优势来谈论他的书也许是有意义的。但尽管如此,这种情绪一直在蔓延。桑达尔·皮查伊 (Sundar Pichai) 认为唾手可得的成果已经消失。有传言称,为什么 OpenAI 的 Orion 被推迟,而 Claude 3.5 Opus 却无处可寻。

加里·马库斯声称自己平反了。尽管这种情况以前发生过,但很多人担心这一次他是对的。

与此同时,主要人工智能实验室内的几乎每个人都相信事情进展得非常顺利,未来两年至少会像过去两年一样疯狂。这是情绪上的重大脱节,是人工智能的分裂。

那么到底是怎么回事呢?

到目前为止,每当模型在一件事上做得更好时,他们在其他方面也会做得更好。这被视为模型的工作方式,并帮助我们相信扩展理论。从 GPT-4 一直到 Claude 3.5 Sonnet,我们都看到了同样的事情。这让我们更加相信这样的假设:当模型在一件事上做得更好时,它们在其他方面也会做得更好。他们展示了迁移学习并展示了新兴能力(或没有)。当然,在某些情况下,您可以对其进行微调,以更好地解决特定的医疗问题或法律问题等,但这些似乎也像是容易实现的目标,很快就会被摘下来。

但后来它开始停滞不前,或者至少没有像最初那样变得更好。缩放来自于交叉熵损失的减少,基本上是模型学习接下来应该说什么,并且这种情况仍在继续下降。但对于我们作为观察者来说,这还没有产生足够明显的影响。到目前为止,我们仍然没有找到在性能上击败 GPT 4 的更大模型,尽管我们已经学会了如何让它们更高效地工作并减少幻觉。

似乎有可能的是,纯粹的预训练扩展带来的收益似乎已经停止,这意味着我们已经成功地将尽可能多的信息融入到每个尺寸的模型中,因为我们使模型变得更大,并向模型中投入了比我们能够做到的更多的数据。到过去。这绝不是我们知道如何使模型更大或更好的唯一方法。这只是最简单的方法吗?这就是伊利亚所暗示的。

我们有多个 GPT-4 类模型,有些好一点,有些差一点,但没有一个比 GPT-4 明显好于 GPT-3.5。

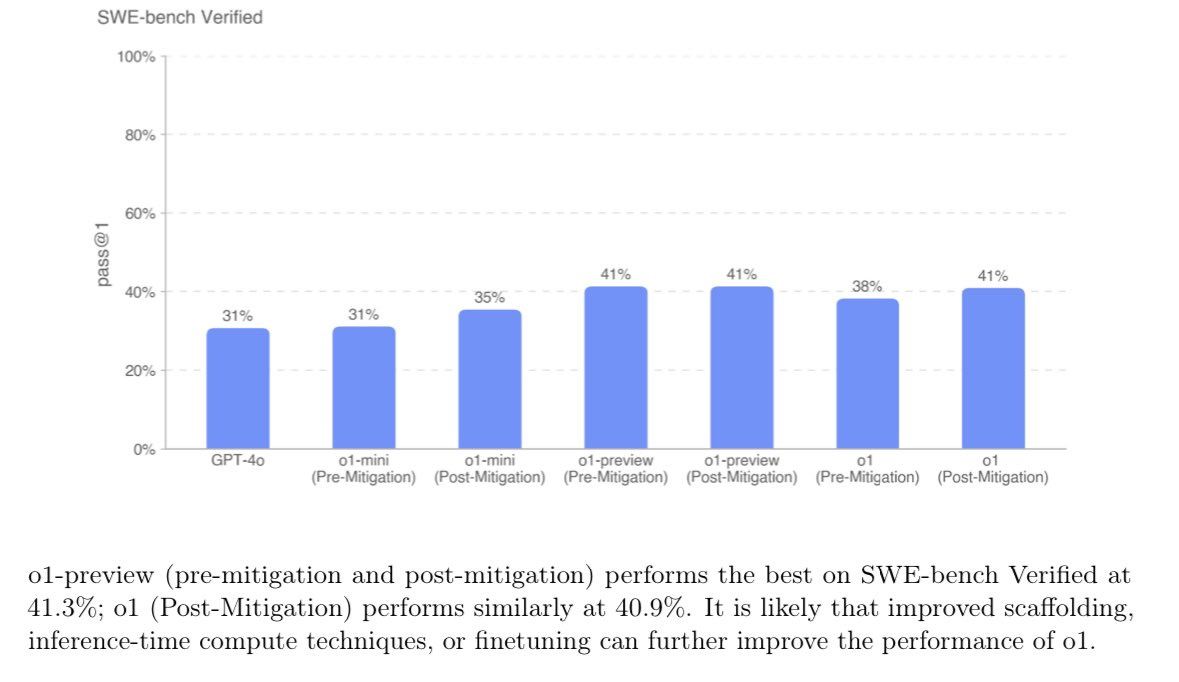

OpenAI 最受期待的模型 o1,在涉及编码之类的事情时,似乎比 Anthropic 之前最先进的模型,甚至是他们自己之前的模型,表现并没有好多少,尽管它抓住了很多人的想象力(包括我的) )。

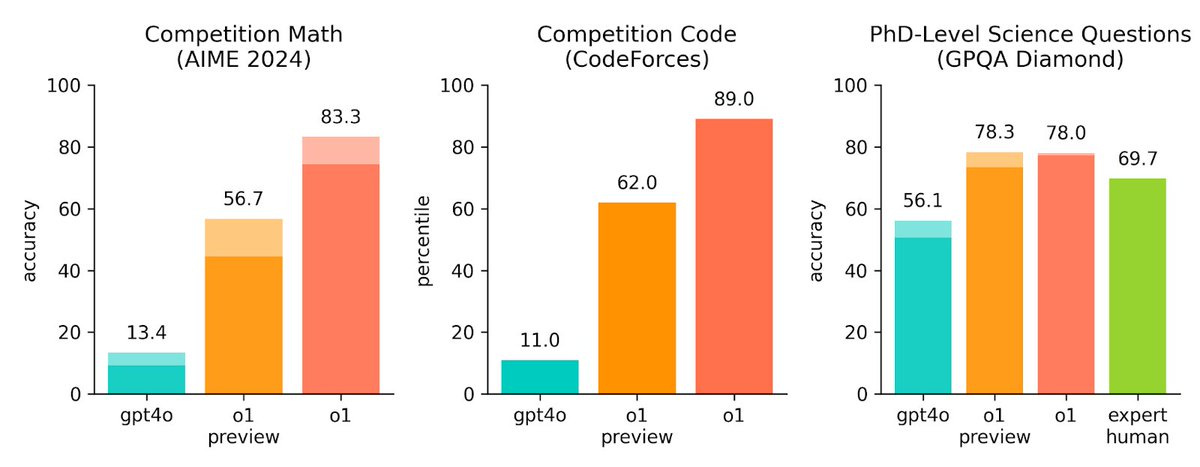

但这也是因为我们评估这些模型的能力受到了打击。例如,o1 在法律推理方面要好得多。人工智能法律公司 Harvey 也这么说。它在代码审查方面也做得更好,而不仅仅是创建代码。它甚至可以解决 83% 的 IMO 数学问题,而 gpt4o 只能解决 13%。综上所述,即使它看起来并不是在所有方面都比 Sonnet 或 GPT-4o 更好,但它在多个领域绝对更好。

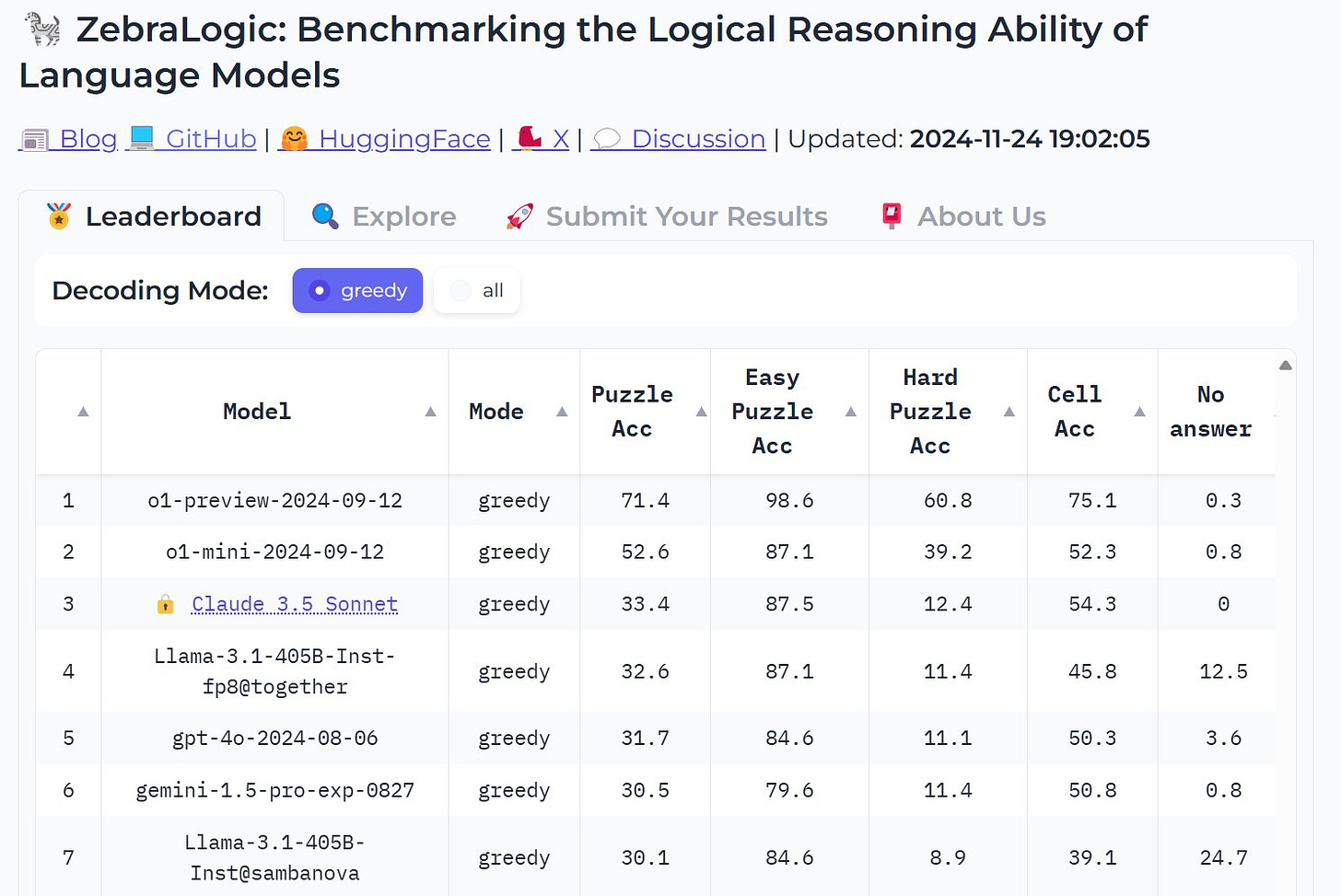

人们确实认为它已经碰壁的一个重要原因是我们用来衡量结果的评估已经饱和。当我详细研究 evals时,我写了这么多。

今天,我们通过各种为测试它们而设立的基准来做到这一点,例如 MMLU、BigBench、AGIEval 等。它假设它们是“有点人类”和“有点软件”的某种组合,因此对它们进行类似于人类应该知道(SAT、GRE、LSAT、逻辑谜题等)以及软件应该做什么(回忆事实、遵守某些标准、数学等)。这些要么是重新设计的人体测试(SAT、LSAT),要么是回忆测试(谁是利比里亚总统),或者是逻辑谜题(将鸡、老虎和人移过河)。即使他们可以做到所有这些,也不足以将它们用于更深层次的工作,例如增材制造、金融衍生品设计或药物发现。

当前模型和 AGI 之间的差距是:1)它们产生幻觉或虚构,并且在任何足够长的分析链中,它都无法追踪自己在做什么。这使得代理变得不可靠。 2)他们不够聪明,无法制定真正有创意或出色的计划。在每次评估中,完成的单个任务似乎都达到了人类水平,但在任何现实世界的任务中,它们仍然远远落后。这个差距非常诱人,因为它看起来很小,但就像芝诺悖论一样,它缩小了,但似乎仍然存在。

但无论我们在预训练方面是否遇到了障碍,或者在当前的评估方法上遇到了障碍,这并不意味着人工智能的进步本身已经遇到了障碍。

那么如何解决脱节问题呢?我认为人工智能发展将继续沿着以下三种主要方式发展。第一,仍然存在数据和训练悬而未决的问题,只是我们还没有使用很多数据。其次,我们正在学习使用合成数据,通过我们拥有的数据和模型来解锁模型实际可以做什么的更多功能。第三,我们正在教授模型推理,在回答问题时进行更长时间的“思考”,而不仅仅是预先教授它需要了解的一切。

-

我们仍然可以扩展数据和计算

首先是仍有大量数据尚未用于训练。还有人担心我们的数据已经用完。伊利亚 (Ilya) 将数据视为化石燃料,是一种有限且会耗尽的资源。

但它们很可能就像化石燃料,当我们开始真正寻找它们时,我们会发现更多。以每桶 100 美元的价格可获得的石油量远远多于以每桶 20 美元的价格可获得的石油量。

即使在较大的模型运行中,它们也不包含我们通常在周围看到的大量数据。 Twitter,最著名的一个。而且,我们谈话的很大一部分。从学术界到商业界,再到坐下来写论文,有关我们如何学习或做事的过程数据。有关我们如何在世界各地移动的数据。来自世界各地闭路电视的视频数据。时态结构化数据。是的,即使在当前多模式模型的训练下,各种模式的数据仍有待挖掘。三维世界数据。科学研究数据。视频游戏玩数据。整个世界或更多的世界仍然有待开采!

还有一些数据并不存在,但我们正在创建。

https://x.com/watneyrobotics/status/1861170411788226948?t=s78dy7zb9mlCiJshBomOsw&s=19

在创建它的过程中,我们很快就会达到极度依赖的地步,就像我们对自动驾驶所做的那样。除此之外,由于折叠衣物通常并不致命,因此它的普及速度会更快。而且没有像齿轮头这样的“洗衣头”来对抗它。这就是几乎所有机器人公司实际上正在做的事情。通过将任务的执行外包给有足够触觉的机器人来创建数据会更便宜!

有了这一切,我们应该想象最大的多模式模型将比现在好得多。即使您不完全相信迁移学习,您也应该想象模型在内部拥有准“世界模型”方面会变得更好,足以显着提高其性能。

说到这……

-

我们正在制作更好的数据

然后是合成数据。这尤其让人们感到困惑,因为他们理所当然地想知道如何在训练中再次使用相同的数据并使其变得更好。这不就是空卡路里吗?这不仅仅是一个糟糕的问题。在人工智能世界中,这将被重述为“它不会为原始预训练数据添加大量新的熵”,但它的意思是一样的。

答案是否定的,(至少)出于三个不同的原因。

-

我们已经使用我们拥有的原始数据进行了多次训练,以更好地学习。高质量的数据集,如维基百科、教科书或 Github 代码,不会被使用一次并在训练过程中被丢弃。它们被多次使用以从中提取最深入的见解。这不应该让我们感到惊讶,毕竟我们通过重复来学习,而模型并没有那么不同。

-

我们可以将拥有的数据转换为不同的格式,以便从中提取最多的数据。人类通过多种不同的方式查看相同的数据来学习。我们阅读多本教科书,为自己创建测试,并且更好地学习材料。有些人只读了一本数学教科书,勉强通过了高中,那就是拉马努金。

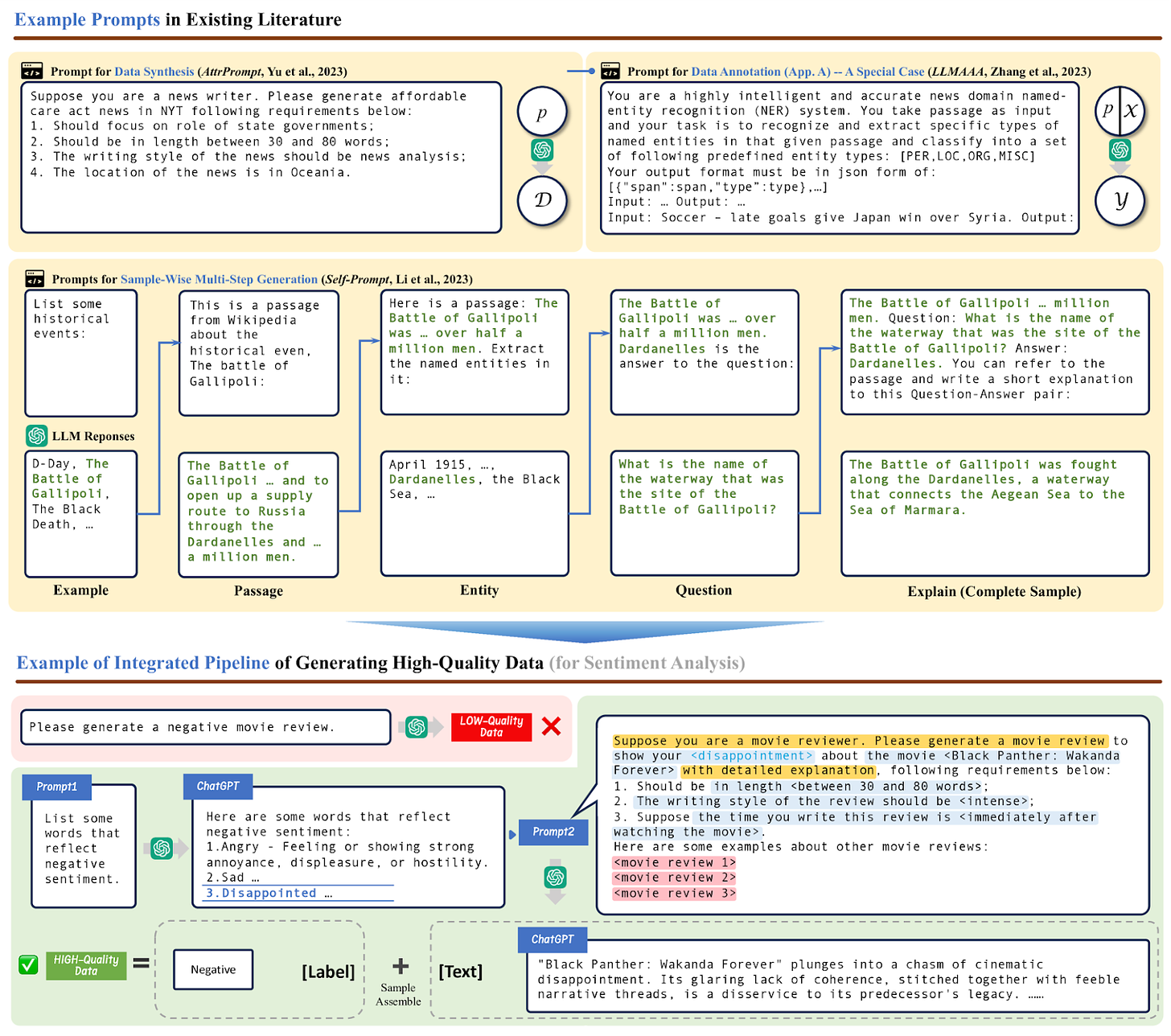

因此,您将数据转换为各种问答格式、图表、表格、图像、上帝保佑的播客,与其他来源结合并增强它们,您可以用它创建一个强大的数据集,不仅用于预训练,还用于整个训练频谱,尤其是前沿模型或推理时间缩放(使用现有模型思考更长时间并生成更好的数据)。 -

我们还创建数据并测试其在现实世界中的有效性。在某种程度上,对论文进行评分是一种艺术形式,而了解一段代码是否运行则不然。如果您想做强化学习,这一点尤其重要,因为“基本事实”很重要,并且更容易分析可编码的主题。 OpenAI 认为这对于法律等领域来说甚至是可能的,我认为没有理由怀疑它们。

有一些论文探索了生成和使用合成数据的各种方式。但特别是对于增强编码性能、增强数学推理或生成更好的推理能力等方面,合成数据非常有用。您可以生成问题的变体并让模型回答它们,填补多样性差距,尝试针对现实场景的答案(例如运行它生成的代码并捕获错误消息)并将整个过程合并到训练中,以制作模型更好的。

如果你把这些加起来,这就是在过去一年左右的时间里引起兴奋的原因,并使实验室里的人们更有信心他们可以让模型更好地工作。因为它是一种从我们现有的数据源中提取洞察力并教导模型更好地回答我们提出的问题的方法。这是迫使我们成为更好的老师的一种方式,以便将模特变成更好的学生。

显然它不是万能药,就像其他一切一样,这也不是免费的午餐。

合成数据的效用并不在于它(仅靠它)可以帮助我们攀登 AGI 之山,而是在于它可以帮助我们继续构建越来越好的模型。

-

我们正在探索新的S曲线

伊利亚的说法是,还有新的山脉需要攀登,还有新的缩放定律需要发现。 “攀登什么”是新的问题,这意味着我们面前还有所有新的S曲线需要攀登。关于它可能是什么有很多讨论——无论是搜索、强化学习、进化算法、混合算法还是其他完全不同的东西。

o1 及其同类是这个问题的一个答案,但绝不是唯一的答案。当前模型的致命弱点是它们非常不擅长迭代推理。思考一些事情,然后时不时地回来尝试其他事情。现在我们在困难模式下逐个标记地执行此操作,而不是在概念空间中以正确的方式执行此操作。但这并不意味着该方法不会(或不能)工作。就像人工智能中的其他事物一样,使其工作所需的计算量远未达到最佳量。

我们刚刚开始教授推理,并在推理时迭代地思考问题,而不仅仅是在训练时。关于它到底是如何完成的仍然存在疑问:是针对 QwQ 模型还是来自中国的 Deepseek r1 模型。是思想链吗?是搜索吗?它是通过 RL 训练的吗?确切的配方尚不清楚,但输出是已知的。

而且输出还不错!事实上,这是最强烈的看跌观点,也是可信的。它指出,因为它经过 RL 训练来“思考更长时间”,并且只能在数学或代码等明确定义的领域进行训练,或者在思维链可能更有帮助并且有明确的基本事实正确答案的情况下,对于其他现实世界的答案来说,它不会变得更好。这是其中的大多数。

但事实证明这不是真的!与 Sonnet 甚至它的前身相比,它在编码方面似乎并没有那么好。好多了,但也没有好多少。在写作之类的事情上也没有那么好。

但毫无疑问,它更擅长的是需要清晰推理的问题。那里的氛围很棒!它可以解决一系列令人眼花缭乱的领域的博士问题。无论是写立场文件,还是分析数学问题,或者写经济学论文,甚至回答《纽约时报》数独问题,都非常非常好。显然它甚至可以提出癌症治疗的新想法。

https://x.com/DeryaTR_/status/1865111388374601806?t=lGq9Ny1KbgBSQK_PPUyWHw&s=19

这是专为专家级工作而设计的模型。基准测试无法反映它有多好并不重要。许多人表示,最好将其视为人工智能的新“GPT 2 时刻”。

矛盾的是,这可能表明基准饱和。在没有用户共鸣的情况下,我们不再能够衡量顶级模型的性能。举个例子,不熟悉尖端物理学的人说服自己o1可以解决量子物理学,结果证明这是错误的。共鸣会告诉我们使用哪种模型、用于什么目标以及何时使用!我们必须把自己变成椒盐卷饼,才能弄清楚使用哪些模型来做什么。

https://x.com/scaling01/status/1865230213749117309?t=4bFOt7mYRUXBDH-cXPQszQ&s=19

这是直到最近我们才忽视的惨痛教训的另一半。能够思考解决方案并搜索更大的可能性空间并在需要重试的地方回溯。

但它将创造一个世界,致力于解决世界上最重要或最困难问题的科学家、工程师和领导者现在可以毫不犹豫地解决这些问题。它几乎不会产生幻觉。它实际上为高科技政策或经济问题提供了令人印象深刻的答案。它用推理回答医学问题,包括一些棘手的鉴别诊断问题。它可以更好地调试复杂的代码。

它远非绝对可靠,但对于任何在一系列令人眼花缭乱的领域进行专家级工作的人来说,它是一个极其强大的催化剂。这甚至还没有提到 Deepmind 内部创建 Alpha 模型系列并试图将其纳入大语言世界的工作。有一个高度丰富的研究生态系统正在拼命尝试构建通用人工智能。

我们正在让模型对世界更加清晰,就像我们让模型更加了解世界一样。人们很容易忘记,这些模型所了解的世界只是通过符号、向量来了解的,这些符号代表了他们从未真正见过或经历过的世界的一部分。我们还致力于让这些模型清晰可见!这很难,因为现实世界非常复杂。

我们现在拥有这些可以控制计算机、编写代码和上网冲浪的模型,这意味着它们可以与任何数字内容交互,前提是有一个良好的界面。 Anthropic 通过创建一个将人工智能助手连接到数据所在位置的协议,发布了第一波攻击。这意味着,如果您想将生物实验室连接到大型语言模型,现在更加可行。

总而言之,这一切意味着我们离人工智能本身还很遥远。我们有更多的数据有待整合,以训练模型在各种模式中表现更好,我们有更好的数据可以在最重要的领域教授特定的课程,并且我们有可以解锁的新范式通过使模型能够“思考更长时间”来实现专家性能。

这会导致下一代模型像猫一样自主,或者像数据一样功能完善吗?不会。或者至少目前还不清楚,但迹象表明不会。但我们拥有第一个可以可靠地加速科学发展的模型。不是以天真的“请证明黎曼假设”的方式,而是足以自行运行数据分析来识别新颖的模式或提出新的假设或调试您的思维或阅读文献以回答特定问题等等每个科学家每天(甚至每小时)都必须做的工作!如果这就是人工智能碰壁时的样子,那确实是一个非常狭隘和迂腐的定义。

感谢您阅读奇怪的循环佳能!免费订阅以接收新帖子并支持我的工作。