单击右下角下载或在 Apple Podcasts、Spotify、Stitcher 等上查找。

在之前的文章中,我认为人工智能系统的目标是打败全人类并取得成功,这存在着真实而巨大的风险。

我首先指出,如果没有具体的对策来防止这种灾难,很可能会发生。然后我认为,由于人工智能安全研究的一些关键困难,对策可能具有挑战性。

但是,虽然我认为错位风险很严重并且会带来重大挑战,但我不同意“我们还没有弄清楚如何对齐 AI,所以如果变革性 AI 很快出现,我们就完蛋了”的观点1 。 ”在这里,我将谈谈我对如何最终避免这种风险的一些高层希望。

我将首先回顾一下挑战,使用 Ajeya Cotra 的年轻商人类比来说明一些核心困难。简而言之,一旦 AI 系统具备足够的能力,就很难测试它们是否安全,因为它们可能会欺骗和操纵我们进行错误的阅读。因此,试图确定他们是否安全可能就像“作为一个八岁的孩子试图在成年求职者之间做出决定(其中一些是操纵性的)”。

然后,我将介绍我认为应对这种情况的三种主要可能性:

- 数字神经科学:也许我们将能够读取(和/或什至重写)AI 系统的“数字大脑”,这样我们就可以知道(并改变)它们“旨在”直接做什么——而不是拥有从他们的行为中推断出来。 (也许八岁的孩子是读心者,甚至是年轻的X 教授。)

- 有限的人工智能:也许我们可以通过以各种方式限制人工智能系统来确保它们的安全——例如,将某些类型的信息排除在训练之外,将它们设计为“近视”(专注于短期而不是长期)目标),或类似的东西。也许我们可以制造出仍然能够执行特定有用任务的“有限人工智能”——比如做更多关于如何在不受限制的情况下实现安全的研究。 (也许八岁的孩子可以限制他们雇用的权限或知识,并且仍然可以让公司成功运行。)

- AI 制衡:也许我们可以使用一些 AI 系统来批评、监督甚至重写其他系统。即使没有一个单独的人工智能系统是安全的,正确的“制衡”设置也可以确保人类利益胜出。 (也许八岁可以让求职者互相评价和批评,这样八岁只需要验证基本的事实主张,就可以知道谁是最佳人选。)

这些是今天很容易想象的一些主要希望类别。关于 AI 安全研究的进一步工作可能会产生更多的想法(以上内容并不详尽 – 请参阅我的更详细的文章,发布到 Alignment Forum 而不是 Cold Takes,了解更多信息)。

我将在这里讨论挑战和希望的原因。我认为,在大多数情况下,如果 AI 项目谨慎行事而不是狂奔,这些希望看起来会好得多。

我认为我们还没有完全了解希望和挑战是如何产生的。在这一点上我能做的最好的事情就是说:“我目前对那些高度相信 AI 接管会或不会发生的人没有多少同情(也就是说,对于任何认为 AI 接管的可能性……低于10% 或 90% 以上。”

挑战

这都是在重述以前的作品。如果你记得非常好,请跳到 下一节。

在之前的文章中,我认为:

- 未来几十年,人工智能系统的发展可能会实现自动化——并显着加快——科学和技术进步,让我们比大多数人想象的更快地进入一个非常陌生的未来。 (更多:最重要的世纪)

- 如果我们通过雄心勃勃地使用当今 AI 开发中常见的“黑盒试错法”来开发这种 AI,那么就会存在很大的风险:

- 这些人工智能会制定意想不到的目标(它们计算和计划的世界状态,就像下国际象棋的人工智能“瞄准”将死);

- 这些人工智能将根据需要欺骗、操纵和压制人类以实现这些目标;

- 最终,这可能会达到人工智能完全从人类手中接管世界的地步。

- 今天人们正在进行人工智能安全研究以防止出现这种结果,但此类研究存在许多深层次的困难:

| “好消息——我已经测试了这个 AI,它看起来很安全。”为什么我们仍然有问题? | ||

| 问题 | 关键问题 | 解释 |

| 兰斯阿姆斯特朗问题 | 我们是否让 AI 变得真正安全或擅长隐藏其危险行为? |

在与智能代理打交道时,很难区分“表现良好”和“表现良好”之间的区别。 当职业自行车运动正在打击提高成绩的药物时,兰斯阿姆斯特朗非常成功,似乎异常“干净”。后来发现他一直在使用毒品,并通过异常复杂的操作来隐藏它们。 |

| 李尔王问题 |

当人类处于控制之下时,人工智能(实际上)表现良好。这会转移到人工智能控制的时候吗? |

很难知道某人在对你有权力时会如何表现,仅基于观察他们在没有权力时的行为。 只要人类处于控制之下,人工智能可能会按预期行事——但在未来的某个时刻,人工智能系统可能具备足够的能力和广泛的应用范围,有机会完全控制世界。很难知道他们是否会抓住这些机会,我们也无法对情况进行彻底的测试。 就像李尔王在放弃王位之前试图决定赋予他的每个女儿多少权力。 |

| 实验室老鼠问题 | 今天的“亚人类”人工智能是安全的。未来的人工智能有更多类似人类的能力吗? |

今天的人工智能系统还不够先进,无法展示我们想要研究的基本行为,例如欺骗和操纵人类。 就像试图通过只在实验室老鼠身上做实验来研究人类医学一样。 |

| 第一次接触问题 |

想象一下,明天的“类人”人工智能是安全的。当人工智能的能力远远超过人类时,事情会怎样发展? |

人工智能系统可能(总体上)变得比人类更有能力,而且……真的很难知道那会是什么样子。据我们所知,银河系中从来没有任何东西在相关方面比人类更有能力!无论我们想出什么来解决前三个问题,我们都不能太自信它会继续工作,如果 AI 进步(或只是扩散)更多。 就像尝试计划与外星人的第一次接触(这几乎不像是类比)。 |

包含这些挑战的类比是 Ajeya Cotra 的“年轻商人” 类比:

想象一下,你是一个 8 岁的孩子,他的父母给你留下了一家价值 1 万亿美元的公司,而且没有值得信赖的成年人作为你走向世界的向导。你必须聘请一位聪明的成年人作为 CEO 来经营你的公司,像父母一样处理你的生活(例如,决定你的学校、你的住所、何时需要去看牙医),并管理你的巨额财富(例如,决定将资金投资于何处)。

你必须根据你想出的工作试用或面试来雇用这些成年人——你看不到任何简历,也不需要做参考调查等。因为你太有钱了,很多人以各种理由申请。 ( 更多)

如果你的求职者是“圣徒”(真正想提供帮助的人)、“马屁精”(只是想让你在短期内开心,即使这对你的长期不利)和“阴谋家”的混合体“(那些想为自己吸走你的财富和权力的人),你 – 一个八岁的孩子 – 如何区分?

(点击展开)关于为什么人工智能可以使这个世纪成为最重要的世纪的更多细节

在最重要的世纪,我认为 21 世纪可能是人类有史以来最重要的世纪,通过先进的人工智能系统的发展,可以大大加快科学和技术的进步,让我们比大多数人想象的更快地进入一个深刻的世界。陌生的未来。

此页面有约 10 页的系列摘要,以及指向音频版本、播客和完整系列的链接。

我在该系列中主张的要点是:

- 长期的未来是完全陌生的。技术的足够进步可能会导致一个持久的、银河系范围内的文明,它可能是一个激进的乌托邦、反乌托邦,或者介于两者之间的任何东西。

- 由于 AI 驱动的生产力爆炸式增长,从长远来看,未来的到来可能比我们想象的要快得多。

- 相关类型的AI 看起来将在本世纪开发– 使本世纪成为将启动并有机会塑造未来银河系文明的世纪。

- 这些说法似乎过于“狂野”,无法认真对待。但是有很多理由认为我们生活在一个狂野的时代,应该为任何事情做好准备。

- 我们,生活在这个世纪的人,有机会对未来的大量人产生巨大影响——如果我们能够充分理解这种情况并找到有益的行动。但是现在,我们还没有为此做好准备。

(点击展开)为什么 AI 会“旨在”打败人类?

之前的一篇文章认为,如果今天的 AI 开发方法直接导致足够强大的 AI 系统,那么默认情况下很可能会发生灾难(在没有具体对策的情况下)。

简单来说:

- 现代人工智能的发展本质上是基于通过反复试验进行的“训练”。

- 如果我们通过这种训练不谨慎而雄心勃勃地前进,并且如果它让我们一路发展到非常强大的人工智能系统,那么这些系统可能最终会针对世界的某些状态(类似于下棋人工智能的目标)将军)。

这些状态将不是我们想要的,因为我们的试错训练方法不会准确。例如,当我们对某些问题感到困惑或被误导时,我们会奖励给出错误答案的 AI 系统——无意中训练欺骗行为。

如果我们的 AI 系统 (a)强大到足以打败人类,并且 (b) 瞄准我们不想要的世界状态,我们应该预料到灾难。 (“击败”意味着控制世界并采取必要措施使我们远离障碍;我不清楚我们是真的被杀死还是被强行阻止1以与 AI 系统的目标相矛盾的方式改变世界.)

(点击展开)人工智能如何打败人类?

在之前的一篇文章中,我认为人工智能系统可以击败全人类,如果(无论出于何种原因)他们旨在实现这一目标。

通过打败人类,我的意思是获得对世界的控制权,以便人工智能而不是人类来决定其中发生的事情;这可能涉及杀死人类或以某种方式简单地“收容”我们,这样我们就无法干扰 AI 的目标。

发生这种情况的一种方式是,如果人工智能变得极其先进,以至于它拥有超越人类所能做到的“认知超能力”。在这种情况下,可以想象单个 AI 系统(或一组协同工作的系统):

对如何构建更好的 AI 系统进行自己的研究,最终形成具有令人难以置信的其他能力的东西。

侵入世界各地的人工软件。

操纵人的心理。

在自身或任何人类盟友的控制下迅速产生巨大的财富。

提出比人类想象的更好的计划,并确保它不会尝试任何人类可能能够检测和阻止的接管尝试。

开发可以快速廉价制造的先进武器,但其威力足以压倒人类军队。

然而,我的文章还探讨了如果每个 AI 系统基本上都具有与人类相似的能力,事情会是什么样子。在这种情况下:

人类可能会在整个经济中部署人工智能系统,这样他们就拥有大量的资源并可以访问许多资源——以及复制自己的能力。

从这个起点开始,具有类似人类(或更强大)能力的人工智能系统将有许多可能的方法来达到其总人口可能超过和/或资源超过人类的程度。

我解决了一些可能的反对意见,例如“没有身体的 AI 怎么可能是危险的?”

数字神经科学

我之前曾争辩说,衡量 AI 系统是否安全可能存在固有的困难,原因如下:不具有欺骗性的 AI 系统可能看起来像 AI 系统,它们非常擅长欺骗,以至于隐藏了所有证据,在我们可以轻松测量的任何方式。

除非我们能“读懂他们的想法!”

目前,当今领先的 AI 研究属于“黑盒试错”类型。人工智能尝试一项任务;根据它是否完成任务,它得到“鼓励”或“沮丧”;它调整了“数字大脑”的线路,以便下次改进;它改进了任务;但我们人类无法充分理解它的“数字大脑”,也无法对它的“思维过程”说太多。

(点击展开)为什么人工智能系统是我们无法理解其内部运作的“黑匣子”?

我所说的“黑盒试错”的意思在旧的 Cold Takes 帖子中有简要解释, Ajeya Cotra (我链接到的部分)和Richard Ngo (第 2 部分)的更多技术文章中有更详细的解释。这是一个快速的、过于简单化的描述。

今天,构建人工智能系统最常见的方法是使用“人工神经网络”(ANN),你可能会认为它有点像一个从空(或随机)状态开始的“数字大脑”:它没有还没有被连接到做特定的事情。遵循这样的过程:

- 人工智能系统被赋予某种任务。

- 人工智能系统会尝试一些东西,最初是非常随机的。

- 人工智能系统获得有关其选择执行情况和/或什么会获得更好结果的信息。在此基础上,它通过调整 ANN(“数字大脑”)的线路来“学习”——实际上是通过加强或削弱一些“人工神经元”与其他神经元之间的联系。这些调整使 ANN 在它做出的选择和它得到的结果之间形成更强的关联。

- 经过足够多的尝试后,AI 系统开始擅长这项任务(最初很糟糕)。

- 但是现在没有人真正知道它如何或为什么擅长这项任务。开发工作已经进入构建一个灵活的架构,以便它从反复试验中学习,并通过进行所有试验和错误来“训练”它。我们大多不能“深入 AI 系统以了解它是如何思考的”。

- 例如,如果我们想知道为什么像 AlphaZero 这样的国际象棋 AI 会走一些特定的棋步,我们不能查看它的代码来找到诸如“控制棋盘的中心”或“尽量不要失去我的”之类的想法女王。”我们看到的大部分只是一大组数字,表示不同人工神经元之间的连接强度。与人脑一样,我们大多只能猜测“数字大脑”的不同部分在做什么。

一些 AI 研究(示例) 2正在探索如何改变这一点——如何解码 AI 系统的“数字大脑”。这项研究处于相对早期的阶段——今天,它只能“解码”人工智能系统的一部分(或者完全解码非常小的、故意简化的人工智能系统)。

随着 AI 系统的进步,解码它们可能会变得更难 – 或者更容易,如果我们可以开始使用 AI 来帮助解码 AI,和/或改变 AI 设计技术以使 AI 系统不那么“黑匣子”。

我认为这里有多种可能性,例如:

失败: “数字大脑”越来越大,越来越复杂,越来越难以理解,因此“数字神经科学”通常与人类神经科学一样难以学习。在这个世界上,我们不会对从事欺骗行为的人工智能系统进行“测谎”之类的事情。

基本的读心术:我们能够处理诸如“人工智能系统是否具有欺骗性行为,例如它是否具有与其陈述相矛盾的关于世界的’信念’的内部表示”和“人工智能系统是否是旨在完成一些我们不打算完成的奇怪目标。”

- 仅仅通过持续的基于试错的训练可能很难解决这样的问题(也许是因为我们担心人工智能系统正在操纵它们自己的“数字大脑”——见后面的要点)。

- 但我们至少能够得到潜在问题的早期预警,或者我们没有问题的早期证据,并适当调整我们的谨慎程度。这种读心术也有助于人工智能制衡(下图)。

高级读心术:我们能够详细了解 AI 系统的“思维过程”(哪些观察和模式是其行为的主要原因),了解这种“思维过程”的任何令人担忧的方面(例如意想不到的目标)出现,并进行许多小的调整,直到我们可以验证人工智能系统没有意想不到的目标或欺骗。

Mind- writing (数字神经外科):我们能够直接改变“数字大脑”,而不是仅仅通过前面讨论的“试错”过程。

数字神经科学的一种潜在失败模式是,如果人工智能系统最终能够操纵自己的“数字大脑”。 ” 这可能会导致“数字神经科学”出现与其他人工智能安全研究相同的问题:如果我们关闭或消极强化基于我们的“读心术”似乎具有不安全“目标”的人工智能系统,我们可能会结束选择那些“数字大脑”只显得安全的人工智能系统。

- 这可能是一个真正的问题,特别是如果 AI 系统最终具有远远超过人类的能力(更多内容见下文)。

- 但天真地,一个人工智能系统操纵自己的“数字大脑”来表现得安全似乎比简单地表现出欺骗性要难得多。

我应该指出,我将大部分(难以解释的)关于引出潜在知识(ELK) 议程的研究都集中在这个类别下。 3 ELK 议程主要是4思考哪些类型的“数字大脑”模式可能与诚实与欺骗相关联,并试图找到一些不可能伪造的诚实标志。

这有多大可能起作用?我认为它现在非常悬而未决。我会说“数字神经科学”是一个年轻的领域,解决的问题可能会或可能不会被证明是容易处理的。如果我们距离变革性人工智能还有几十年的时间,那么我预计至少会在“基本的读心术”方面取得成功,而如果我们的时间少于十年,我认为大约是 50/50。我认为我们不太可能成功实现一些更雄心勃勃的目标,但绝对有可能。

有限的人工智能

我之前讨论过为什么人工智能系统最终会有“目标”,即它们进行计算、选择和计划以达到某种特定的世界状态。例如,下国际象棋的人工智能“瞄准”将死游戏状态;推荐算法可能“旨在”提高客户参与度或满意度。然后我争辩说,人工智能系统会“不惜一切代价”来实现它们的“目标”,即使这意味着欺骗和剥夺人类的权力。

但 AI 系统不一定具有会带来麻烦的那种“目标”。考虑两个不同的任务,你可以通过反复试验(奖励任务成功)来“训练”人工智能来完成:

- “如果某个特定的人处于您的情况,请编写他们会编写的任何代码。”

- “编写任何代码来实现目标 X [包括想出比人类做得更好的东西]。”

第二个似乎是实现我所说的那种雄心勃勃的“目标”的秘诀是危险的——这是一个开放式的邀请,可以做任何能在目标上取得良好表现的事情。相比之下,第一个是关于模仿特定的人。它为创造性的、不可预测的行为以及导致与人类发生冲突的“雄心勃勃”的目标留下了更小的空间。

(有关此区别的更多信息,请参阅我对基于过程的优化的讨论,尽管我对此并不感到兴奋并希望以后写出更好的东西。)

我的猜测是,在竞争激烈的世界中,人们将能够通过第二种方法更快地完成更多工作。但:

- 也许第一种方法一开始会更好,和/或 AI 开发人员出于安全原因会尽可能多地坚持使用第一种方法。

- 也许这足以构建 AI 系统,这些 AI 系统本身可以进行大量适用于未来、限制更少的系统的 AI 对齐研究。或者足以构建可以做其他有用事情的 AI 系统,例如创建令人信服的风险演示,修补危险的 AI 系统否则会利用的安全漏洞,等等。 (更多关于“如何安全的人工智能可以防止危险的人工智能”在未来的文章中。)

- 一个仍然存在的风险:这些 AI 系统可能还能够进行大量研究,使 AI 变得更大、更有能力。因此,仅仅拥有“可以进行对齐研究的 AI 系统”本身是不够的——我们需要希望领先的 AI 开发人员优先考虑安全研究,而不是抢先构建更强大的系统,直到他们可以使更强大的系统安全。

我们可以通过许多其他方式“限制”人工智能系统以确保它们的安全。人们可以想象 AI 系统是:

- “目光短浅”或“近视”:他们可能有仅适用于他们短期未来的“目标”(请参阅上一篇文章了解我所说的这个词的含义)。因此,人工智能系统的目标可能是获得更多能量,但仅限于接下来的几个小时;这样的 AI 系统不会表现出我担心的某些行为,例如以看似“安全”的方式欺骗性地表现,以期在以后获得更多权力。

- “狭隘”:他们可能只有一组特定的能力,例如他们可以帮助人工智能对齐研究,但不了解人类心理,不能欺骗和操纵人类。

- “没有野心”:即使人工智能系统制定了意想不到的目标,这些目标也可能是它们很容易满足的目标,导致一些奇怪的行为,但并不是为了打败全人类。

另一个希望的源泉:即使这种“有限”系统本身不是很强大,我们也可以通过设置 AI 的组合来增强它们,这些 AI 可以在困难的任务上协同工作。例如:

- 一个“缓慢但深入”的 AI 可能会对其采取的每个动作进行大量分析——例如,当它编写一行代码时,它可能会为该行考虑数百种可能性。

- 另一个“快速而浅薄”的人工智能可能会被训练成快速、有效地模仿“缓慢而深入”的人工智能所采取的各种行动——编写它在考虑数百种可能性后生成的各种代码行。

- 可能会训练更多的 AI 来总结其他 AI 的分析,将任务的不同部分分配给不同的 AI 等。结果可能类似于具有不同角色的 AI 的“团队”,这样大量有限的 AI 最终会出现比任何单独的 AI 都强大得多(而且,根据细节,也更危险)。

我猜想,在竞争激烈的世界中,不受“限制”的人工智能系统将——至少最终——变得更强大、更通用,最终更有用。但有限的人工智能可能会让我们走得更远。

这有多大可能起作用?我猜想我们最终将能够构建非常强大的 AI,其限制使它们相对安全。然而,我也猜测没有这些限制的 AI 最终会更强大。所以我认为很多事情的进展将取决于我们的谨慎程度:我们是否会坚持使用有限的 AI,直到我们让更强大的AI 变得安全为止?而且我认为很难预测世界会有多少谨慎 – 这在一定程度上取决于随着时间的推移对本系列中讨论的问题的理解程度!

人工智能制衡

我担心的核心是人工智能可能擅长“欺骗”人类的想法:熟练地选择人类不完全理解的行动方案,并且不会发现问题。这对于人工智能如何首先制定意想不到的“危险”目标以及它们如何通过击败人类来实现这些目标都很重要。

我们可以通过使用 AI 相互监督和批评来缓解这个问题。

一个简单的例子:假设我们担心人工智能系统可能会发现计算机安全漏洞,并伺机利用它们来获取权力和资源。我们可以训练一些人工智能系统专门寻找、暴露和修补计算机安全漏洞。 (一个脚注解释了为什么我们可能期望这样的专业系统修补他们发现的大多数漏洞,而不是像不太专业的系统那样频繁地利用这些漏洞。5 )

- 这是“使用一些 AI 来识别其他 AI 可能导致的潜在问题”的基本示例。

- 一个不错的特性:可能存在一些漏洞,AI 系统比人类更容易注意到这些漏洞;这些可能是我们最应该担心的,也是最有可能被“发现漏洞的人工智能”发现的。

类似地,我们可以训练人工智能系统做如下事情:

- 对彼此提出的计划提出批评,并解释这些计划如何导致意外行为。

- 帮助实现 上述“数字神经科学”目标:分析彼此的“数字大脑”,并就是否有证据表明人工智能系统是否有意想不到的、危险的“目标”进行有说服力的讨论。

- 对彼此的行为进行随机审计:寻找另一个人工智能系统的行为可能具有欺骗性或无意的任何方式。

- 重要的是,与他们正在审核的 AI 相比,审核员 AI 会有不同的“激励”(他们对不同的行为会得到积极的强化):被审核的 AI 系统可能正在寻找人类高度评价的问题的任何答案,而“ auditor”可能会专门寻找令人信服的论据,证明一个在其他方面评价很高的答案实际上是误导性的。

- 我之前曾争辩说,这类审计有局限性——它们最终可能会在不知不觉中训练被审计的人工智能系统,使其能够有效地欺骗人类审计员。但在这种情况下,欺骗审计员可能更像是在欺骗他们自己的副本,这可能是一种更难学习的行为。

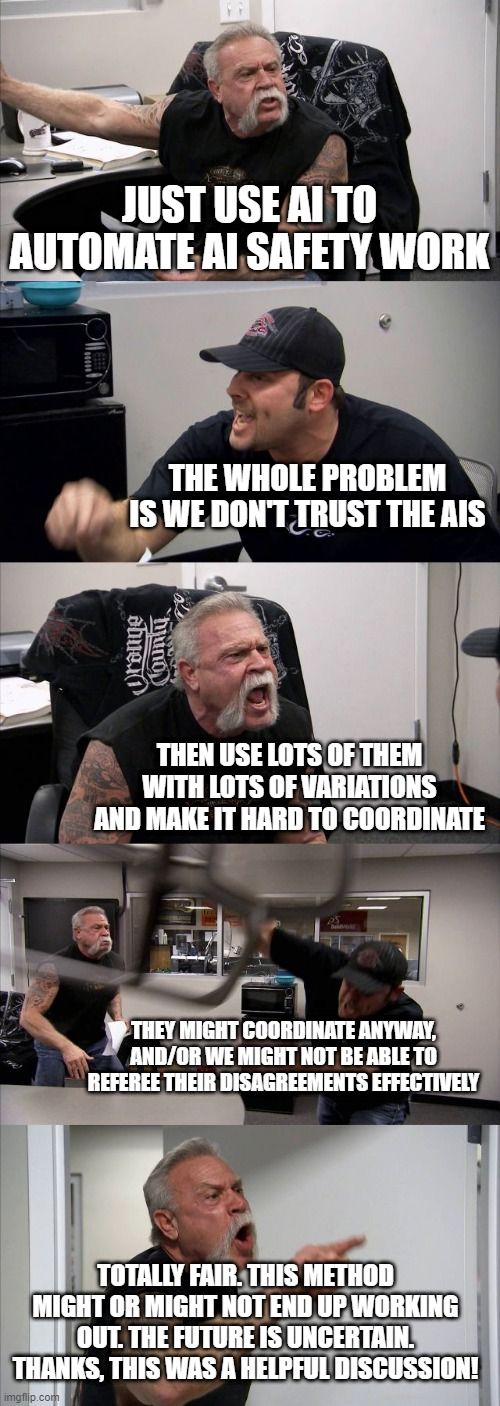

这里有很多潜在的皱纹,我在一篇更详细的非 Cold-Takes 文章中对此进行了讨论。简单来说:

- 如果不同的人工智能系统最终相互协调以对抗我们,人工智能的制衡可能会失败。例如,即使是审计员 AI 系统也可能通过避免警告人类他们在其他 AI 中发现的最重要问题来最好地实现其雄心勃勃的、意想不到的目标。

- 我们可能会尝试通过创建相互“检查和平衡”的 AI 系统集合来降低这种可能性,同时彼此之间的差异足以使协调变得困难。

- AI 制衡的另一种方式可能会失败:当一个 AI 系统批评另一个系统时,由此产生的“辩论”可能很快变得难以进行,以至于人类无法有效地进行裁判。例如,假设一个8 岁的孩子要求成人 A 寻找成人 B 欺骗他们的迹象,成人 A 现在争辩说这正在发生,而成人 B 则争辩说这不是。八岁的孩子能弄清楚真相是什么吗?似乎真的不确定(并且取决于细节)!

已经有一些关于“使用 AI 相互批评”的研究。最近的一个例子是这篇论文,它实际上确实表明,受过训练来评论自己的答案的 AI 可以提出有用的评论,帮助人类更准确地评价它的答案。

其他可能性

我在Alignment Forum文章中更详细地讨论了可能的希望。而且我认为“未知的未知数”有很大的范围:从事人工智能安全研究的研究人员可能会想出还没有人想到的方法。

高度恐惧:事情变得太奇怪、太快

我不想以积极的方式结束,而是想谈谈一种普遍的动态,感觉它可能会使情况变得非常困难,并使上述任何希望都难以实现。

引用我之前的文章:

也许在某个时候,人工智能系统将能够做这样的事情:

- 彼此协调得非常好,以至于使用一个 AI 来帮助监督另一个是没有希望的。

- 完全理解人类的思维和行为,并且确切地知道该说什么话让我们做他们想做的事——所以只要让人工智能发送电子邮件或写 Tumblr 帖子就可以让它在世界上拥有巨大的力量。

- 操纵他们自己的“数字大脑”,这样我们 “读懂他们的想法”的尝试适得其反并误导我们。

- 以与人类完全不同的方式思考世界(即制定计划以实现其目标),诸如“glooble” 6之类的概念是非常有用的思考世界的方式,但人类经过几个世纪的努力仍无法理解.

在这一点上,无论我们为使类人人工智能系统安全、诚实和受限而开发的任何方法都可能失败——并且悄无声息,因为这样的人工智能系统可以从“诚实和乐于助人”转变为“看起来诚实和乐于助人,同时设置有机会打败人类。”

我不拘泥于上述任何细节,但我认为“AI 系统变得极其强大、奇怪且难以快速应对”的普遍动态可能出于以下几个不同的原因:

- 人工智能发展的本质可能就是这样,我们很快就会从拥有非常弱的人工智能系统转变为拥有“超级智能”系统。这有多大的可能性已经争论了很多。 7

- Even if AI improves relatively slowly, we might initially have a lot of success with things like “AI checks and balances,” but continually make more and more capable AI systems – such that they eventually become extraordinarily capable and very “alien” to us, at which point previously-effective methods break down. ( More )

- The most likely reason this would happen, in my view, is that we – humanity – choose to move too fast. It’s easy to envision a world in which everyone is in a furious race to develop more powerful AI systems than everyone else – focused on “competition” rather than “caution” (more on the distinction here ) – and everything accelerates dramatically once we’re able to use AI systems to automate scientific and technological advancement.

So … is AI going to defeat humanity or is everything going to be fine?

I don’t know! There are a number of ways we might be fine, and a number of ways we might not be. I could easily see this century ending in humans defeated or in a glorious utopia . You could maybe even think of it as the most important century.

So far, I’ve mostly just talked about the technical challenges of AI alignment: why AI systems might end up misaligned, and how we might design them to avoid that outcome. In future pieces, I’ll go into a bit more depth on some of the political and strategic challenges (eg, what AI companies and governments might do to reduce the risk of a furious race to deploy dangerous AI systems), and work my way toward the question: “What can we do today to improve the odds that things go well?”

Footnotes

-

Disclosure: my wife Daniela is President and co-founder of Anthropic, which employs prominent researchers in “mechanistic interpretability” and hosts the site I link to for the term. ↩

-

Disclosure: I’m on the board of ARC , which wrote this document. ↩

-

Though not entirely ↩

-

The basic idea:

- A lot of security vulnerabilities might be the kind of thing where it’s clear that there’s some weakness in the system, but it’s not immediately clear how to exploit this for gain. An AI system with an unintended “aim” might therefore “save” knowledge about the vulnerability until it encounters enough other vulnerabilities, and the right circumstances, to accomplish its aim.

- But now imagine an AI system that is trained and rewarded exclusively for finding and patching such vulnerabilities. Unlike with the first system, revealing the vulnerability gets more positive reinforcement than just about anything else it can do (and an AI that reveals no such vulnerabilities will perform extremely poorly). It thus might be much more likely than the previous system to do so, rather than simply leaving the vulnerability in place in case it’s useful later.

- And now imagine that there are multiple AI systems trained and rewarded for finding and patching such vulnerabilities, with each one needing to find some vulnerability overlooked by others in order to achieve even moderate performance. These systems might also have enough variation that it’s hard for one such system to confidently predict what another will do, which could further lower the gains to leaving the vulnerability in place. ↩

- This is a concept that only I understand. ↩

-

See here , here , and here . Also see the tail end of this Wait but Why piece , which draws on similar intuitions to the longer treatment in Superintelligence ↩

原文: https://www.cold-takes.com/high-level-hopes-for-ai-alignment/