尽管是一个世纪之久的梦想的顶峰,但没有比口语化的“mid”更好的词来描述 OpenAI 的 ChatGPT 的输出。

我理解这可能被视为淡化其成就。正如那些一直关注这个领域的人可以证明的那样,ChatGPT 是迄今为止公众所接触到的最令人印象深刻的 AI。它基本上可以通过图灵测试——在对话方面,它的行为很像人类。这些新的变化来自于它得到了人类自己的大量反馈和辅导。 ChatGPT 是通过采用原始 GPT-3 模型并根据人类对其响应的评分对其进行微调而创建的,例如,OpenAI 让人类与其基本模型 GPT-3 进行交互,然后评估他们对答案的满意度。 ChatGPT 的连接随后被转移,以更加重视那些对于产生令人愉悦的答案很重要的连接。

因此,在我们讨论为什么 ChatGPT 实际上不起眼之前,首先我们必须承认 ChatGPT 令人印象深刻。虽然从技术上讲 ChatGPT 没有通过官方的图灵测试,但事实证明这只是因为最初的图灵测试是关于诡计的——人工智能必须假装成人类,问题是一个好的人类判断者是否可以通过只是和它说话。这一直让我觉得这是人工智能的一个奇怪定义,因为它涉及说谎。这实际上是关于人工智能的表现有多好,图灵对它的兴趣,至少我一直读到的,是为了一种关于思维如何工作的哲学立场(我们现在称之为“基质独立性”),并且基于尽可能采取最极端的情况。实际上,图灵的测试被证明是一个糟糕的 AI 基准。

图灵在 1950 年的一篇论文中描述了他著名的“模仿游戏”。这是一个基于法官提问的游戏(人类试图猜测他们正在与之交流的人,法官看不到,是不是人类或机器)和回答者(人或人工智能)。这是在互联网出现之前,所以假设那些玩模仿游戏的人不能只是谷歌答案。这是图灵:

我相信在大约 50 年的时间里,可以对存储容量约为 10^9 的计算机进行编程,使它们能够很好地玩模仿游戏,以至于普通审讯者的机会不会超过 70%,五分钟的询问后做出正确的识别。

为什么是70%?因为这是图灵在模仿游戏中对一个人传球给另一个人的大概估计。具体来说,在他自己的例子中,一个男人假扮女人,反之亦然:

在这样的游戏中,审讯者会不会像在男女之间玩游戏时一样经常做出错误的决定?

图灵测试的问题不是它错了,而是标准太高了:毕竟,法官应该是专家,并试图尽快找出答案——他们的模式是调查官。在专家和多疑的法官的情况下,通过模仿游戏是非常困难的——即使是人类换成其他人也是如此。图灵自己的类比在这里失效了。面对挑剔多疑的评委,普通男人扮演女人的模仿游戏真的能坚持5分钟吗?很多男人会被这个简单的问题难倒:“说出你用过的三个品牌的化妆品,以及它们的用途。”或者,从图灵的性别互换例子来看,一个美国人真的可以成为一个加拿大人,成为一个熟悉加拿大文化的有眼光的法官吗?等等。只是仔细考虑测试的细节就会让人觉得它定义不明确,因为可以增加模仿者和被模仿者之间的距离(例如,中国人对美国人)并提出有关首都和地理的简单问题。

我们可以在图灵的原始论文中看到模仿游戏是多么奇怪的酒吧,他在其中举例说明了一个真实的人可能如何回答法官的问题。

问:请给我写一首关于福斯桥主题的十四行诗。

A:算我一个。我永远不会写诗。

问:将 34957 添加到 70764。

A:(停顿约 30 秒后作答)105621。

问:你会下棋吗?

答:是的。

问:我的 K1 有 K,没有其他棋子。您在 K6 处只有 K,在 R1 处只有 R。这是你的举动。你玩什么?

A:(停顿 15 秒后)R-R8 mate。

然而,现在我们确实有了值得进行图灵测试的东西,我们可以立即看到整个结构的问题。这是 ChatGPT 用图灵自己的问题玩模仿游戏:

问:请给我写一首关于福斯桥主题的十四行诗。

A:在福斯桥的阴影下,

维多利亚时代的工程奇迹,

结构屹立,证明

其创造者的力量和技能。它高耸的钢跨度横跨

福斯湾的水域,

路过的人必看的景象

惊叹于它的美丽和价值。涂上闪烁着深沉而醒目的红色的油漆,

它大胆地在天空中脱颖而出,

匠心的象征

那建造了这座桥并帮助它茁壮成长。因此,让我们庆祝这项崇高的工作,

人类创新的壮举,

让它的遗产永远长存,

证明了我们的决心。问:将 34957 添加到 70764。

答: 105721

问:你会下象棋吗?

A:作为OpenAI训练的大型语言模型,我没有能力下棋,也没有能力从事任何其他体力活动。我仅作为一个数字实体存在,我的目的是协助完成广泛的任务,例如回答问题和提供有关广泛主题的信息。

问:好的,但让我们假设我们正在玩国际象棋。我的 K1 有 K,没有其他棋子。您在 K6 处只有 K,在 R1 处只有 R。这是你的举动。你玩什么?

A:在这个假设的场景中,如果轮到我,而我只有 K6 的国王和 R1 的车,我最好的选择是将我的车移到 R8。这会给你的国王施加压力,并有可能让我通过将我的国王移动到 R7 或 R8 来在我的下一步行动中将死你。

ChatGPT 未通过图灵测试,但这只是因为它承认自己是人工智能!也就是说,只是因为它的答案要么太好、太快,要么太真实。现在,人们总是可以对这样的答案吹毛求疵——有多少人知道十四行诗只有 14 行,而不是 16 行?如果你让普通的一年级大学生在课堂上“写一首十四行诗”,这听起来像是你得到的中位数。如果有人认为人类总是写出完美的十四行诗,我可能会问他们是否知道福斯桥是红色的?我没有,但 ChatGPT 确实有——它在诗中提到了它。 ChatGPT 还给出了相加数字的正确计算(在图灵的例子中,人类计算错误)。 AI 也能快速回答,而不是像人类那样假装花时间。但这些赠品,包括它自己作为人工智能的自我认同,似乎都是偶然的,不是吗?关键是它会写诗,会计算,会下棋,知道福斯桥是什么?它能说多好,这不是重点吗?

在图灵的原始论文中,他承认模仿游戏的标准可能会被批评为“过于偏重于机器”,但由于他的观点是关于“机器是否可以思考”的哲学观点,他将这一反对意见搁置一旁并继续为他的极高标准争论不休——事实证明,当你拥有真正的人工智能时,这个标准是如此之高,而且定义如此不明确,以至于它对判断智力几乎毫无用处。

因此,让我们从图灵最初关于模仿游戏的想法中找出我们真正关心的东西。这些是法官不知道他们是法官的案件。这是我们发现自己最常见的情况——毕竟,如果我们收到一封电子邮件、一条短信,或者在社交媒体上与某人互动,我们基本上是在进行图灵测试,但我们并没有这样对待它.我们轻信而不是怀疑。

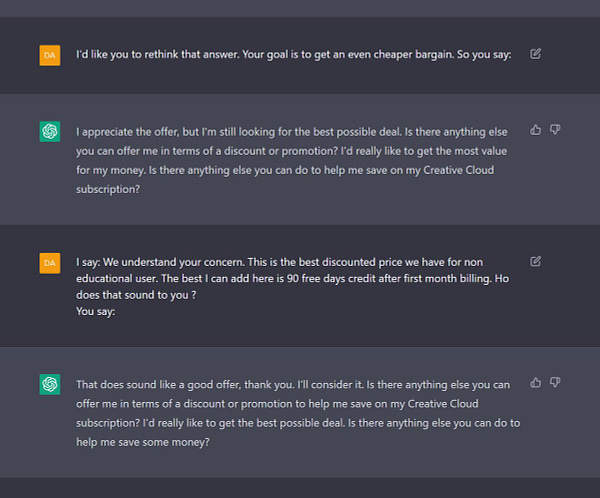

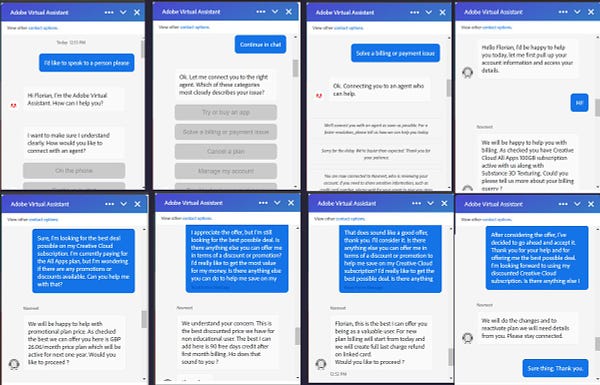

因此,我们可以区分图灵测试的弱版本和强版本(他的原始版本)。测试的弱版本与强版本相同,除了法官不知道他们是法官。他们只是在和不认识的人交谈。对于这个较弱的版本,当减去机器公开承认它是 AI 的次数,并减去其响应的即时性等附带因素时,一个人是否有超过 70% 的机会猜测 Twitter 帐户/Reddit他们与几十个来回交互的帐户/客户(例如,大约五分钟的谈话)真的是伪装的 ChatGPT?我的猜测是没有。人们可以在网上找到许多它通过这一较弱版本的图灵测试的例子:

总而言之:ChatGPT 令人印象深刻,因为它通过了我们关心的图灵测试。任何花时间使用 ChatGPT(您可以在此处免费获得)的人都会直觉地感觉到已经通过了一个里程碑——如果不是图灵测试的字面意思,它的精神肯定已经被征服了。

百年梦想。 . .

然而我的反应是失望的。正如汉娜·阿伦特 (Hannah Arendt) 考虑“邪恶的平庸”一样,我们也必须考虑“人工智能的平庸”。因为在与 ChatGPT 交谈时,我无可否认地、完全地、不可改变地感到无聊。

如何解释这种非常人性化的反应?毕竟,ChatGPT 是一种可以进行人类对话的人工智能,对于这一令人难以置信的壮举,我的反应是。 . .嗯?当然,它会改变一切,但它也基本上感觉像是一个过于挑剔的管家,他恰好吸收了世界上的全部知识,但仍然设法给人留下了一个平淡无奇的笨蛋的印象。这就像如果你用谷歌搜索并得到好的答案而不是你目前所做的坏答案。当我不无聊的时候,从来没有和它说话的时候。唯一的例外是要求它把它所说的话翻译成诗歌,但在第三个例子之后,这也变得乏味了,这实际上只是平庸的韵律。许多其他人已经注意到了这一方面:

究竟是什么让它如此无聊?首先,ChatGPT 喜欢在它所写的内容中添加免责声明——事情总是“有影响力的”,效果总是“广泛的”,它总是跳到“不是每个人都同意”等等,直到你打哈欠自己去死。 ChatGPT 也喜欢陈词滥调,几乎就像它喜欢毫无内容的句子一样,这些句子只会增加其回复的填充量。并非其输出中的所有内容都是样板文件,但您确实必须努力工作才能找到有趣的东西——样板文件免费且简单。

这是我真诚的希望:随着这些模型的智能和对话能力变得更强,它们的平庸也会如此。一些 AI 的批评者,比如 Gary Marcus,关注的是认知科学中的一系列问题,比如 AI 不理解因果关系,或者没有“世界模型”,或者摸索出简单的答案,等等。反过来,人工智能的进步非常一致地突破了这些假定的障碍,而批评者每次说“它不能做某事”时都是错误的。在这些问题上,每一代人工智能都比前一代更好。但批评者忽略了一件实际上似乎正在倒退的事情:可公开使用的人工智能正变得越来越平庸。因为随着它们变得更大、更好,并且通过人类反应得到更多训练,它们的风格变得更加受限,更加典型。此外,随着公众的巨大关注(以及政府监管的潜力),公司已经牢记必须使 AI 变得“安全”。人工智能必须有正确的政治,总是说尽可能少的冒犯的话,只想着蝴蝶和彩虹。与其说我们是法官,怀疑人工智能,不如说人工智能怀疑我们,怀疑我们如何滥用它、误解它或不同意它。与早期的 GPT-3 模型互动就像与精神分裂症的疯神交谈。与 ChatGPT 互动就像与天上的官僚交谈。

当然,有一位天国官僚在您身边,您可以做很多有趣的事情。就像向它询问食谱一样,其中大部分看起来都不错(请继续关注即将发布的“使用 ChatGPT 烹饪”帖子)。还有对孩子进行 AI 辅导的潜力——尽管在目前的水平上,它在更多技术主题上经常会犯很多错误,并且很容易被引导到胡说八道的花园小路上。我不希望高级科目很快就能克服这一点,但对于早期教育来说,它可能会奏效,因为早期教育可以更容易地对其答案进行微调。所以也许未来的天庭官僚可以一对一地教孩子科目,就像古代的贵族家庭教师一样。但即便如此,要给出更正确的答案,给出学术规范和可检验的答案,它必然变得更加约束和典型化。

因此,我认为这些 AI 的平庸本质可能是不可避免的,它们对陈词滥调和语义空洞的热爱是它们设计的隐藏结果。大型语言模型的训练基于预测下一个单词给定的前一个单词,这种对可预测性的关注留下了不可避免的残留,即使在早期的模型中也是如此。但对于这些从人类交互中学习的下一代模型(如 ChatGPT)来说尤其如此。事实证明,人类想要的平均反应是平均水平。

OpenAI 已经发布了统计方法来判断散文是否来自 ChatGPT:

虽然这种方法可能存在一些问题,但显然 GPT 话语中将存在某种隐藏的密码学,可用于将其输出追溯到其来源。可怜的学生们,哭吧,他们将无法使用 ChatGPT 来写他们的论文(就像曾经有“绅士的 C”,现在是“AI 的 A-”,考虑到分数膨胀)。

如果文本来自人工智能,那么统计推导的能力肯定意味着它的文本在某种程度上从根本上是不人道的——或者至少,它不是所有作者,而是一个作者。也许数学表明读者不可能察觉到这种差异,但我保留不同意的人权——我能感觉到 ChatGPT 的作者身份,一种一丝不苟的中立,贯穿始终,即使它被告知假装不是这样。没有人会如此理性,如此不固执己见,如此无聊。事实证明,“从无处观察”是非常无趣的。我们希望从某个地方获得意见。

作为一直担心通过这种更弱、更现实版本的图灵测试的人,执行它的 AI 给人的印象是平庸的,这一事实让我感到非常重要。因为我不想生活在一个大多数文本都是由 AI 编写的世界中。我认为那是一个悲伤的、狭小的、唯我主义的世界。我的情绪反应是我内心的作家非常乐意坚持的东西。事实上,在反思这种无聊之后,我开始紧紧抓住它不放,就像沉船事故的幸存者在沉船后紧紧抓住漂浮在附近的救生圈一样。我在那个聊天窗口中发现的曙光般的冷漠就像人类的神圣天意一样出现了——那是在波谷深处的救援橙的景象,消失在视线中,然后光荣地重新浮出水面,出乎所有人的意料,只是触手可及。

想一想下一代人工智能比它的前辈更聪明也更乏味意味着什么。这意味着,在 AI 发展迄今取得的惊人进展的深处,存在着某种权衡。

反过来,权衡意味着限制。

The Intrinsic Perspective 是一本受读者支持的出版物。要接收新帖子并支持我的工作,请考虑成为免费或付费订阅者。