当你读到这样一个句子时,你过去的经验告诉你它是由一个有思想、有感觉的人写的。而且,在这种情况下,确实有人在输入这些词:[Hi, there!]。但如今,一些看起来非常像人类的句子实际上是由经过大量人类文本训练的人工智能系统生成的。

人们习惯于假设流利的语言来自一种思考,感觉是人类,以至于相反的证据可能很难绕开你的脑袋。人们如何驾驭这个相对未知的领域?由于一直倾向于将流畅的表达与流畅的思维联系起来,因此认为如果 AI 模型能够流畅地表达自己,这意味着它的思维和感觉就像人类一样,这是很自然的——但可能会产生误导。

因此,一位前谷歌工程师最近声称谷歌的人工智能系统 LaMDA 具有自我意识,因为它可以雄辩地生成关于其所谓感受的文本,这也许并不令人惊讶。这一事件和随后的媒体报道导致了一些正确的怀疑文章和帖子,这些文章和帖子声称人类语言的计算模型是有感知的,意味着能够思考、感受和体验。

人工智能模型具有感知能力意味着什么这个问题很复杂(例如,参见我们同事的看法),我们的目标不是解决这个问题。但作为语言研究人员,我们可以利用我们在认知科学和语言学方面的工作来解释为什么人类很容易陷入认为可以流利使用语言的实体是有知觉、有意识或智能的认知陷阱。

使用 AI 生成类人语言

由 Google 的 LaMDA 等模型生成的文本很难与人类编写的文本区分开来。这一令人印象深刻的成就是几十年来建立生成语法、有意义语言的模型的计划的结果。

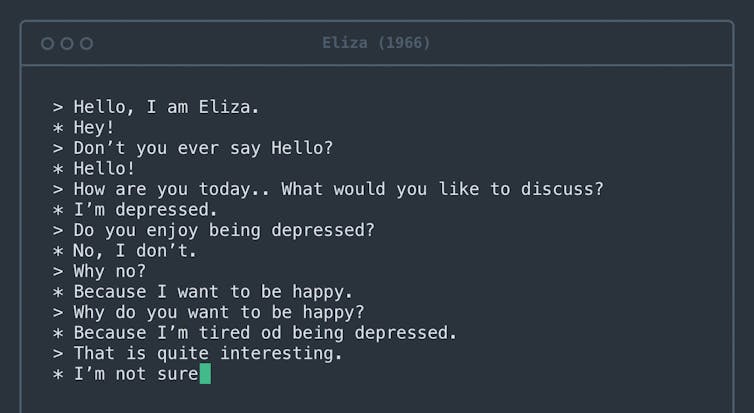

第一个让人们参与对话的计算机系统是半个多世纪前建立的名为 Eliza 的心理治疗软件。图片来源: Rosenfeld Media/Flickr ,CC BY

第一个让人们参与对话的计算机系统是半个多世纪前建立的名为 Eliza 的心理治疗软件。图片来源: Rosenfeld Media/Flickr ,CC BY

至少可以追溯到 1950 年代的早期版本被称为 n-gram 模型,它只是简单地计算特定短语的出现次数,并用它们来猜测在特定上下文中可能出现的单词。例如,很容易知道“花生酱和果冻”比“花生酱和菠萝”更可能是一个短语。如果你有足够的英文文本,你会一次又一次地看到短语“peanut butter and jelly”,但可能永远不会看到短语“peanut butter and pineapples”。

今天的模型、数据集和近似人类语言的规则在几个重要方面与这些早期尝试不同。首先,他们基本上是在整个互联网上接受培训的。其次,他们可以学习相距甚远的单词之间的关系,而不仅仅是相邻的单词。第三,它们受到大量内部“旋钮”的调整——数量之多,以至于即使是设计它们的工程师也很难理解为什么它们会生成一个单词序列而不是另一个单词序列。

然而,模型的任务与 1950 年代相同:确定下一个可能出现的单词。今天,他们非常擅长这项任务,以至于他们生成的几乎所有句子都看起来流畅且合乎语法。

花生酱和菠萝?

我们要求一个大型语言模型GPT-3来完成句子“花生酱和菠萝___”。它说:“花生酱和菠萝是很好的组合。花生酱和菠萝的甜味和咸味相得益彰。”如果有人这么说,可能会推断他们曾经一起尝试过花生酱和菠萝,形成意见,并与读者分享。

但是 GPT-3 是如何提出这一段的呢?通过生成适合我们提供的上下文的单词。然后是另一个。然后是另一个。该模型从未见过、摸过或尝过菠萝——它只是处理了互联网上所有提到它们的文本。然而,阅读这一段可以引导人类的思维——甚至是谷歌工程师的思维——将GPT-3想象成一个可以推理花生酱和菠萝菜肴的智能生物。

人脑天生就可以推断出文字背后的意图。每次您进行对话时,您的大脑都会自动构建对话伙伴的心理模型。然后,您使用他们所说的词语在模型中填写该人的目标、感受和信念。

从单词跳转到心智模型的过程是无缝的,每次收到完整的句子时都会触发。这种认知过程为您在日常生活中节省了大量时间和精力,极大地促进了您的社交互动。

然而,在人工智能系统的情况下,它会失灵,凭空建立一个心智模型。

更多的探索可以揭示这种失火的严重性。考虑以下提示:“花生酱和羽毛一起味道很好,因为___”。 GPT-3 继续说道:“花生酱和羽毛搭配在一起味道很好,因为它们都有坚果味。花生酱也很光滑,乳脂状,有助于抵消羽毛的质地。”

本例中的文本与我们的菠萝示例一样流畅,但这次模型说的显然不太明智。人们开始怀疑 GPT-3 从未真正尝试过花生酱和羽毛。

将智能赋予机器,否认人类

具有讽刺意味的是,使人们将人性归因于 GPT-3 的相同认知偏见可能导致他们以不人道的方式对待真实的人类。社会文化语言学——在社会和文化背景下对语言的研究——表明,假设流利的表达和流利的思维之间过于紧密的联系会导致对说话方式不同的人的偏见。

例如,具有外国口音的人通常被认为不那么聪明,并且不太可能获得他们合格的工作。类似的偏见存在于不被认为有声望的方言的人,例如美国的南方英语,对使用手语的聋人,以及对口吃等语言障碍的人。

这些偏见是非常有害的,经常导致种族主义和性别歧视的假设,并且一次又一次地被证明是没有根据的。

流利的语言并不意味着人性

人工智能会变得有感觉吗?这个问题需要深思熟虑,哲学家们确实思考了几十年。然而,研究人员已经确定,当语言模型告诉你感觉如何时,你不能简单地信任它。言语可能会产生误导,很容易将流利的言语误认为是流利的思想。 ![]()

本文根据知识共享许可从The Conversation重新发布。阅读原文。

图片来源: Tancha / Shutterstock.com