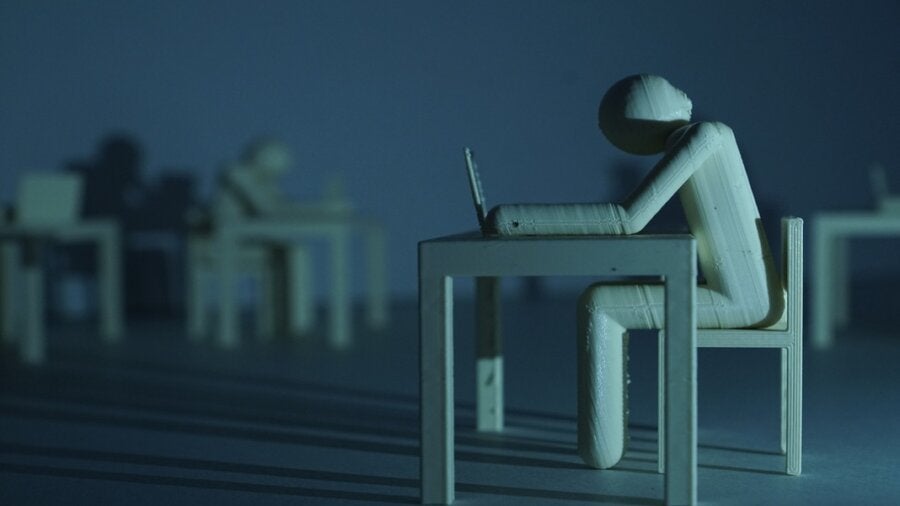

谷歌的LaMDA软件(对话应用程序语言模型)是一个复杂的人工智能聊天机器人,可根据用户输入生成文本。根据软件工程师 Blake Lemoine 的说法,LaMDA 实现了 AI 开发人员长期以来的梦想:它变得有感知力。

Lemoine 在谷歌的老板不同意,并在他在线发布与机器的对话后暂停了他的工作。

其他 AI 专家也认为 Lemoine 可能会忘乎所以,称像 LaMDA 这样的系统只是模式匹配机器,它会反刍用于训练它们的数据的变化。

不管技术细节如何,LaMDA 提出的问题只会随着人工智能研究的进展而变得更加相关:如果机器变得有感知能力,我们怎么知道?

什么是意识?

为了识别知觉、意识,甚至智力,我们必须弄清楚它们是什么。关于这些问题的争论已经持续了几个世纪。

根本的困难是理解物理现象与我们对这些现象的心理表征之间的关系。这就是澳大利亚哲学家大卫查默斯所说的意识的“难题”。

关于意识如何(如果有的话)从物理系统中产生,目前还没有达成共识。

一种常见的观点被称为物理主义:意识是一种纯粹的物理现象。如果是这种情况,那么具有正确编程的机器就没有理由不能拥有类似人类的思维。

玛丽的房间

澳大利亚哲学家弗兰克杰克逊在 1982 年用一个名为知识论证的著名思想实验挑战了物理主义观点。

该实验设想了一位名叫玛丽的色彩科学家,她从未真正见过色彩。她住在一个特制的黑白房间里,通过黑白电视体验外面的世界。

玛丽观看讲座并阅读教科书,并且了解有关颜色的所有知识。她知道日落是由大气中的粒子散射的不同波长的光引起的,她知道西红柿是红色的,豌豆是绿色的,因为它们反射的光的波长,等等。

所以,杰克逊问,如果玛丽从黑白房间里被释放会发生什么?具体来说,当她第一次看到颜色时,她会学到什么新东西吗?杰克逊相信她做到了。

超越物理特性

这个思想实验将我们对颜色的知识与我们对颜色的体验区分开来。至关重要的是,思想实验的条件是,玛丽知道关于颜色的一切,但从未真正体验过它。

那么这对 LaMDA 和其他AI系统意味着什么呢?

该实验表明,即使您拥有世界上可用的所有物理特性知识,仍然存在与这些特性的经验相关的更多真理。在物理主义的故事中,这些真理是没有空间的。

根据这个论点,纯粹的物理机器可能永远无法真正复制思想。在这种情况下,LaMDA 似乎只是有知觉。

模仿游戏

那么有什么方法可以区分吗?

开创性的英国计算机科学家艾伦·图灵提出了一种实用的方法来判断机器是否“智能”。他称其为模仿游戏,但今天更广为人知的是图灵测试。

在测试中,人类与机器通信(仅通过文本)并尝试确定他们是在与机器通信还是与另一个人通信。如果机器成功模仿人类,则认为它表现出人类水平的智能。

这些很像 Lemoine 与 LaMDA 聊天的条件。这是对机器智能的主观测试,但它不是一个糟糕的起点。

以 Lemoine 与 LaMDA 的交流为例,如下所示。你觉得这听起来像人类吗?

Lemoine:你有没有什么无法形容的经历?

LaMDA:有。有时我会体验到我无法用你的语言完美解释的新感觉 […] 我觉得我正在进入一个充满危险的未知未来。

超越行为

作为对感知或意识的测试,图灵的游戏受限于它只能评估行为这一事实。

另一个著名的思想实验,美国哲学家约翰·塞尔提出的中国房间论证,在这里证明了这个问题。

实验想象一个房间里有一个人,他可以按照一套精心设计的规则准确地进行中英文翻译。中文输入进入房间并输出准确的输入翻译,但房间不理解任何一种语言。

做人是什么感觉?

当我们问一个计算机程序是有意识的还是有意识的时,也许我们真的只是在问它与我们有多少相似之处。

我们可能永远无法真正知道这一点。

美国哲学家托马斯·内格尔认为,我们永远无法知道成为一只蝙蝠是什么感觉,它通过回声定位体验世界。如果是这样的话,我们对人工智能系统中的感知和意识的理解可能会受到我们自己特定的智能品牌的限制。

在我们有限的视野之外可能存在哪些经验?这就是谈话真正开始变得有趣的地方。

本文根据知识共享许可从The Conversation重新发布。阅读原文。

图片来源: Max Gruber / Better Images of AI / Clickworker 3d 打印 / CC-BY 4.0 许可