很多人都非常信赖大语言模型 (LLM) 人工智能来编写代码。很多人骂他们。据 [Joe Spracklen] 和 USTA 的其他研究人员称,还有一些人可能正在计划利用它们的特性。至少,研究人员发现了“振动编码”的潜在漏洞。

每个攻读过法学硕士学位的人都知道他们有“产生幻觉”的倾向——也就是说,会偏离轨道,制造出听起来似乎有道理的胡言乱语。当你进行氛围编码时,这些乱码很可能会出现在你的程序中。通常,这仅意味着错误。然而,如果您在使用包管理器的环境中工作(例如 Node.js 中的 npm、Python 中的 PiPy、R-studio 中的 CRAN),那么那些看似合理的无意义代码最终可能会调用一个假包。

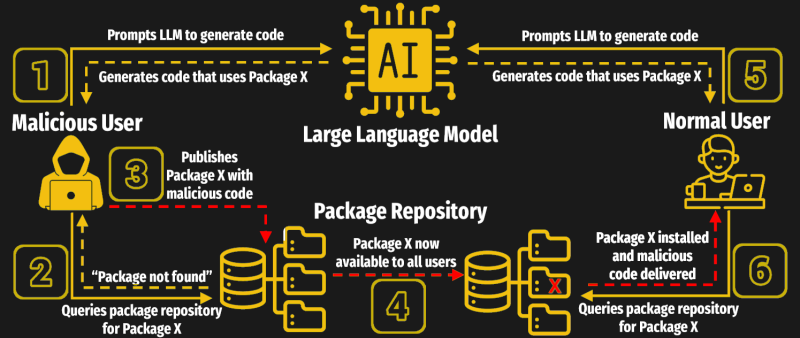

聪明的攻击者可能能够确定 LLM 产生的幻觉是哪种错误包,并将它们作为恶意代码的载体注入。这比您想象的更有可能 – 虽然 CodeLlama 是最严重的罪犯,但测试的最准确模型 (ChatGPT4) 仍然以超过 5% 的比率生成这些错误包。研究人员在全文中提出了一些缓解策略,但这提醒我们,人工智能不能承担责任。最终,要由我们程序员来确保代码以及代码中包含的库的完整性和安全性。

我们刚刚对氛围编码进行了热烈的讨论,你们中的一些人似乎对此很感兴趣。其他人一致认为ChatGPT 是有史以来最糟糕的暑期实习生。不管喜欢还是讨厌,这可能不会是我们最后一次听到这种新编程方法带来的安全问题。

特别感谢 [Wolfgang Friedrich] 将其发送到我们的举报热线。

原文: https://hackaday.com/2025/04/12/vibe-check-false-packages-a-new-llm-security-risk/