“十年之内,可以想象 60-80% 的工作岗位可能会消失,而且其中大部分都不会被取代。”

人工智能首席执行官非常喜欢发表这样的言论。因为他们做出了这些陈述,我们被迫从表面上理解它们,然后试图弄清楚其中的含义。

从历史上看,关于比较优势的争论已经谈到了在各个部门和技术转型中发挥的作用。不过,人工智能首席执行官和支持者表示,这次有所不同。

他们也把钱放在嘴边。 OpenAI刚刚启动了Stargate 项目。

Stargate Project 是一家新公司,计划在未来四年内投资 5000 亿美元,在美国为 OpenAI 建设新的人工智能基础设施。我们将立即开始部署 1000 亿美元。

这清楚地表明了这样一个事实:我们将投入无数的资金,曼哈顿计划或阿波罗任务级别的资金,以实现这个未来。

但如果我们想为这个社会做好准备,我们还必须更好地预测世界可能是什么样子。有很多未知因素,包括我们可以预期的进展速度和突破,这就是为什么这种对话经常涉及极端假设,如“全面失业”或“建造戴森球”或“数据中心有数百万诺贝尔奖获得者”。

感谢您阅读奇怪的循环佳能!免费订阅以接收新帖子并支持我的工作。

然而,我想尝试并接地它。因此,以下是我们确实了解的一些有关人工智能及其资源使用的具体信息。

-

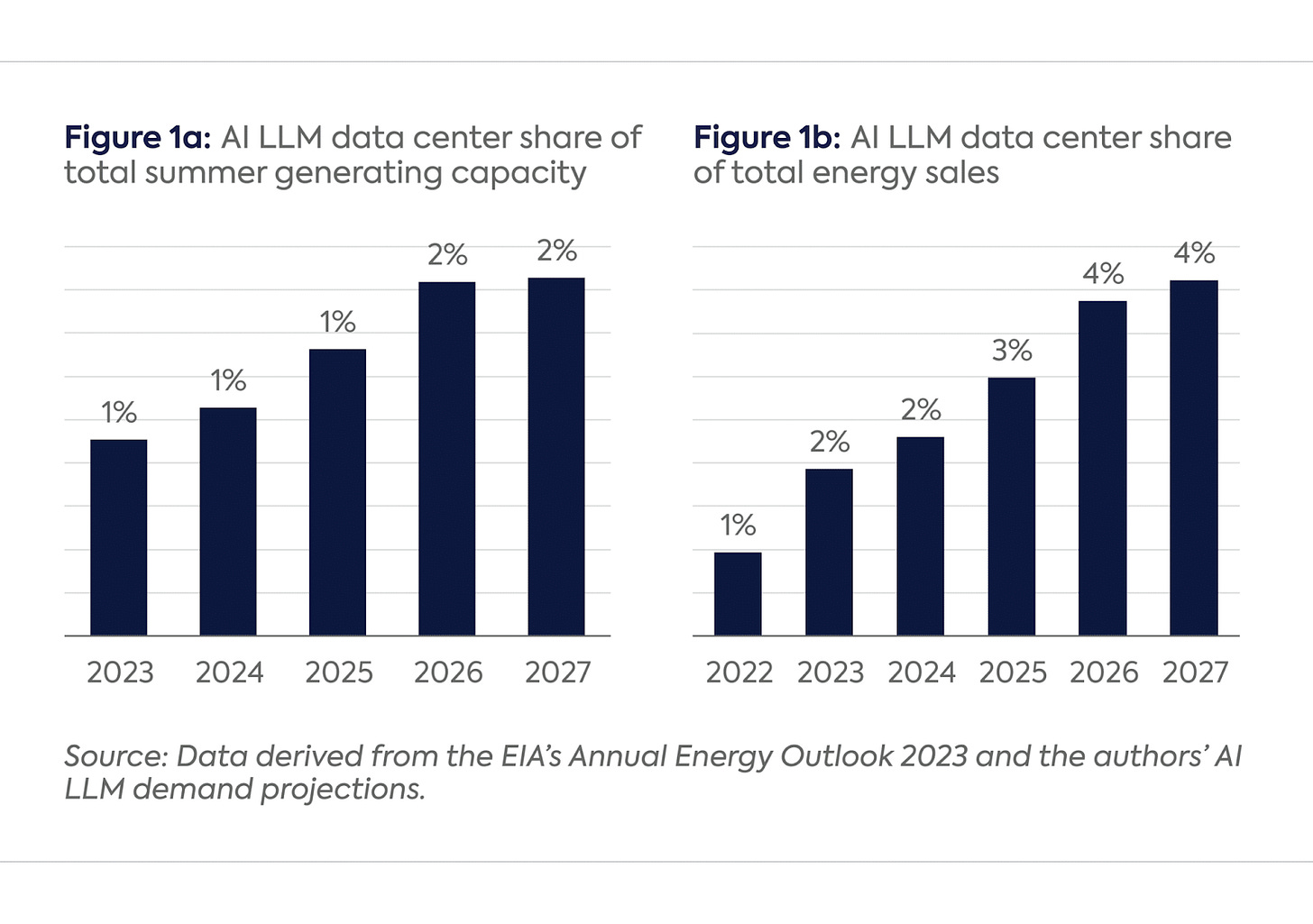

在人工智能浪潮的推动下,到 2030 年,数据中心将消耗美国约 12% 的电力消耗

-

支持数据中心最重要组件(包括图形处理单元 (GPU) 和中央处理单元 (CPU) 服务器、存储系统、冷却和网络交换机)的关键电力预计在 2023 年至 2026 年间将增加近一倍,达到 96 吉瓦( GW)到 2026 年在全球范围内;仅人工智能操作就可能消耗超过 40% 的电力

-

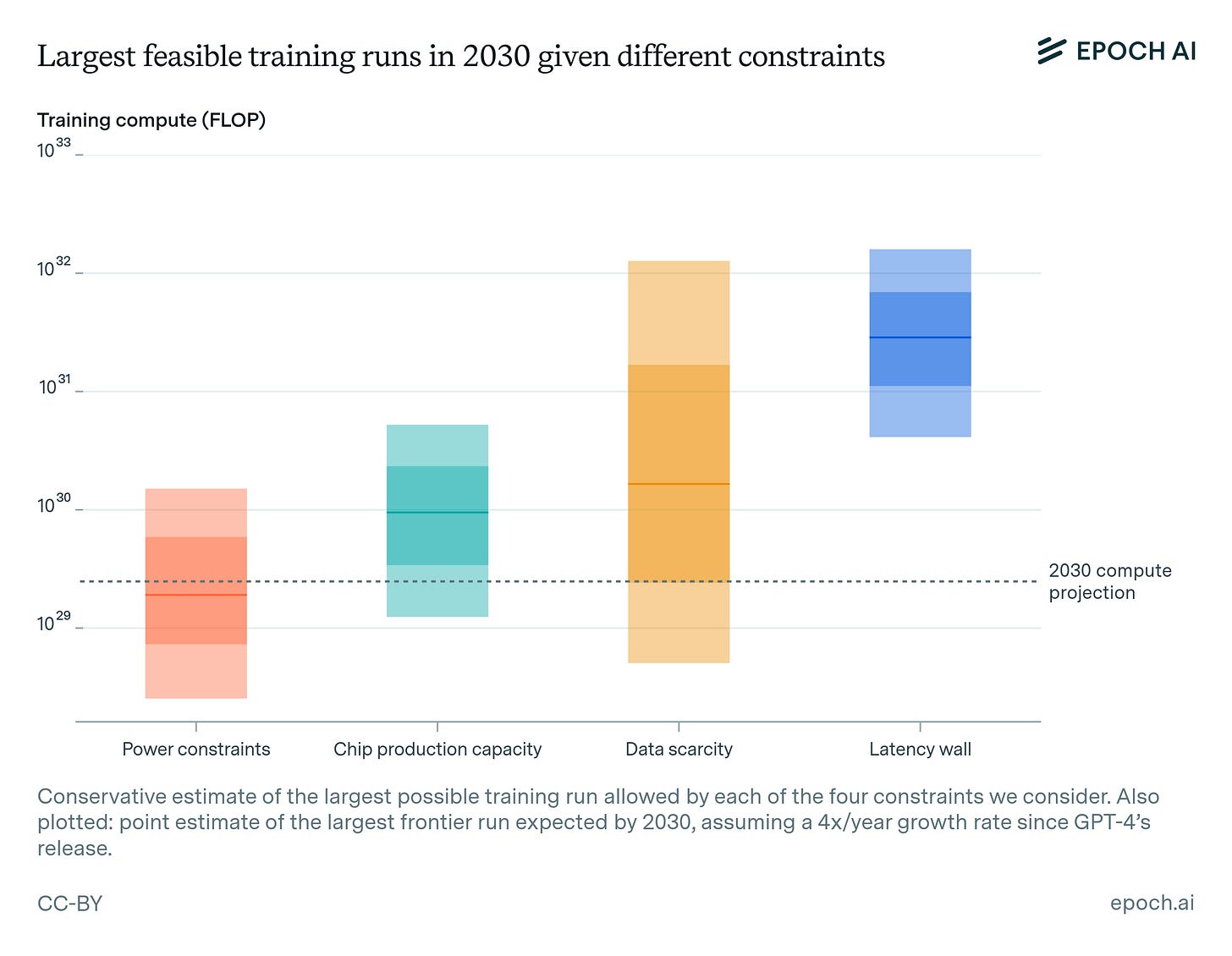

据Epoch称,AI 模型训练能力预计将大幅提升,到 2030 年将达到 2e29 FLOP。但他们还补充道,“数据移动瓶颈限制了 LLM 扩展超过 2e28 FLOP,并且在 2e31 FLOP 处存在“延迟墙”。我们可能会在大约 3 年内实现这些目标。”

-

H100 GPU 的平均功耗约为 500W(SXM 较高,PCIe 较低)。顺便说一句,到 2022 年,用于 AI 的 GPU 的运行功率为 400 瓦,而 2023 年用于第一代 AI 的最先进 GPU 的运行功率为 700 瓦,2024 年下一代芯片的运行功率预计为 1,200 瓦。

-

H100 GPU在数据中心的实际使用寿命相对较短,在60-70%的高利用率运行时为1-3年。按照 Meta 的使用率,这些 GPU 的年故障率约为 9%。

-

OpenAI 在 o1-pro 模型上因每年 2400 美元的订阅而亏损,而 o1-preview 每百万输入代币的成本为 15 美元,每百万输出和推理代币的成本为 60 美元。因此,盈亏平衡点约为 360 万个代币(如果输入:输出比例为 1:8),这将需要约 100 小时(每次响应 2 分钟)和每代 1000 个代币。

-

o3 模型在高计算模式下每个任务的成本约为 2000-3000 美元。对于 ARC 基准测试,它针对 100 个任务,在低计算模式(1.3 分钟)下使用了 3300 万个令牌,在高计算模式下使用了 57 亿个令牌(13 分钟)。每个推理链生成大约 55,000 个代币。

-

推理成本似乎每年下降 10 倍。

-

如果一个查询同时外包给 64 个 H100(对于大型 LLM 推理很常见),您只需为这些 GPU 支付 64 × (3-9 美元/小时) = 192-576 美元/小时。

-

如果查询的总计算时间约为 4-5 个 GPU 小时(例如,64 个 GPU 上的 5 分钟 → 约 5.3 个 GPU 小时),则仅一次推理就可能花费数千美元 — 特别是如果您按需支付云费率。

-

现在,为了完成一项任务,人们使用大约 20-30 个 Claude Sonnet 调用,持续 10-15 分钟,如果需要修复它们,则使用 2-300 万个代币进行干预。对于一个优秀的程序员来说,另一种选择是花费 30-45 分钟。

-

Devin,您可以聘请的软件工程师,每月费用为 500 美元。为内部代码库创建测试套件大约需要 2 小时,自动创建基准数据可视化则需要 4 小时。这可以被认为是 AGI 的一个非常便宜但也非常糟糕的版本,因为它经常失败,但我们假设这可以达到“足够好”的覆盖范围。

我们现在可以对这个 AGI 新世界做出一些假设,看看资源需求是什么样的。

例如,当我们迈向自主代理的世界时,一个重大变化可能是它们可以用于长期规划,被用作“员工”,而不仅仅是“工具”。

目前,o3 运行查询最多可能需要 3000 美元和 13 分钟。在 64 个 H100 上运行 5 分钟,总共大约需要 0.3 个 GPU 小时,这可能会花费几千美元。这与报道的大型计算通行证1 的2 000-3 000 美元数字相符。

但 Devin,这位每月 500 美元的软件工程师,可以在 2-4 小时内完成一些任务(例如创建测试套件、数据可视化等)。一个月内,大约有 160 个工作小时,相当于每小时 3-4 美元。不幸的是,它还不够好,但一旦我们得到 o3 或 o5 可能就足够了。这比现在的 o3 便宜 1000 倍,大致是如果未来几年这种趋势持续下去的话,它会便宜的数量级。

现在我们需要看看 AGI 需要有多大。由于成本和缩放曲线,我们假设我们设法创建一个 AGI,该 AGI 可在一台 H100 或每个成本为 500W 的同等设备上运行,其成本大约是 Devin 的一半左右。它的使用寿命为几年。

如果假设成立,我们可以看看我们将有多少电力,然后反算出可以同时运行多少个 GPU 以及有多少个 AGI“员工”。

现在,到 2030 年,数据中心将使用美国 12% 的电力。美国每年消耗约 4000 TWH 的电力。如果人工智能消耗其中的 40%,则每年为 192 太瓦时。连续运行 H100 每年大约需要 4.38 MWh。

所以这意味着我们可以运行大约 4400 万个并发 H100 GPU。实际上,如果存在电力和过热等问题,则意味着其中大约一半是更实际的数字。

如果我们考虑一下全球数字,这个数字将会翻一番——大约有 7600 万个最大并发 GPU 和 4000 万个日夜工作的现实 AGI 代理。

我们还从预计到 2026 年覆盖全球数据中心的 96GW 关键电力中得到了相同的数字。

现在我们可能会以不同的方式实现这一点,我们会构建更大的推理代理,我们会提炼他们的思维并创建更好的基础模型,然后重复。

毕竟,如果主要缺乏的是理解和遵循复杂推理步骤的能力,那么我们能够生成的此类推理越多,事情就会越好。

为了实现这一目标,我们一开始需要大约 3300 万个 GPU,使用寿命约为 1-3 年,这基本上是全球可能生产的全部。 Nvidia 的目标是每年生产 15-200 万台左右,因此需要加快步伐。

在大规模情况下,HPC 设置也会受到更常见的限制(网络结构带宽、内存容量或 HPC 集群利用率)的影响。一些中心指出,高带宽内存包的成本正在飙升,这些限制可能与 GPU 供应一样受到限制。

此外,现代领先的晶圆厂(如台积电的 5 nm/4 nm)每月可运行约 30,000 片晶圆。每个晶圆:直径 300 毫米,产量可能约为 60 个良好的 H100 级芯片(芯片尺寸约为 800 平方毫米,考虑到产量)。每年大约有 2100 万个 GPU。

整个半导体行业、能源行业和人工智能行业基本上必须重新布线,并成为世界经济的一个更大的组成部分。

美国的劳动力资源为1.68亿人。劳动力参与率为 63%,无论如何,到 2030 年将创造约 1100 万个就业岗位。由于这里的 AGI 不睡觉也不吃东西,所以工作时间增加了三倍。这相当于劳动力增加一倍,生产力和智商也可能增加一倍。

(是的,许多工作需要物理表现和能力,但我认为如果需要的话,通用人工智能可以操作/远程操作机器或机器人。)

现在如果我们稍微放松假设会发生什么?最重要的是我们获得了另一项研究突破,我们不需要 GPU 来运行 AGI,他们会变得那么高效。这可能是真的,但很难建立超越“按比例增加所有数字”的模型,而且很多人都这么认为。

其他的则更有趣。如果 AGI 并不意味着真正的 AGI,而是更像 OpenAI 的定义,即它可以完成 90% 的人类任务,会发生什么?或者,如果它最擅长数学和科学,但仅限于这些,而你必须运行很长时间怎么办?尤其是,如果大肆吹嘘的“代理”没有发生,他们可以同样出色地解决复杂的任务,例如,“如果你把他们放在高盛交易室或刚果的丛林中,并通过任何方式工作”它需要解决问题”,但是更专业吗?

如果 AGI 不能完美替代人类怎么办?

如果人工智能不能完美替代,但仍然需要我们纠正他们的工作、提供反馈等,那么瓶颈很大程度上仍然是人和他们的决策。这意味着未来增长的形式看起来很像(极其成功的)生产力工具。你会面临失业和更多的经济活动,但这看起来可能是经济繁荣的好时机。

关键在于这是否意味着我们会发现新的工作领域。考虑到你必须想象的条件,是的! “我们还无法想象的工作”的可能性是劳动经济学中的一个常见观点(Autor、Acemoglu 等),但他们在历史上是正确的。

但有一个转折。如果从“完成 60% 好”到“完成 90% 好”的步骤只需要收集 10 万个任务完成方式的示例,该怎么办?在我看来,这对于很多任务来说都是很有可能的。这意味着大多数工作或许多工作都会将明确的数据收集作为其流程的一部分。

我可以想象一份工作,你完成某些任务足够多,以至于它们可以被人工智能教授,以足够的保真度收集数据,调整他们的思维链,调整他们学习的环境,并不断测试和调整他们所处的边缘情况。失败。持续工作→评估→调整循环。

换句话说,这些工作将有一个截止日期,或者至少有一个“持续创新或发现边缘案例”的议程。对于大多数或许多人来说,他们仍然需要获得相当高的报酬,这也是因为鲍莫尔效应,但总的来说,看起来更像是所有事情的质量保证。

如果 AGI 不通用怎么办

我们可以花更多的钱在几个问题上取得超人的突破,而不仅仅是招募 4000 万新工人。即使假设命中率较小且能量消耗较大,这也可能更加有用。

即使假设在某些领域需要 1000 倍的努力并且成功率为 1%,这仍然是 400 次突破。它们都是“你需要的只是注意力”级别,还是“黎曼猜想”级别或“广义相对论”级别?疑。考虑到研究这些问题的天才的岁月和数量,看看这些是多么罕见。

但即使是少数这样的人才也是不可避免的、非凡的。他们将启动整个新产业。他们会帮助科学突破。撰写具有非凡影响力并被引用的论文,从而改变行业。

我敢打赌,这将最大程度地提高科学生产力,与突破性论文方面的停滞作斗争,并与困扰科学的日益严重的老年人统治作斗争。

有趣的是,它们也是最不能直接货币化的。看看我们如何将博士学位货币化。一旦对价值有了清晰的认识,就像博士现在进入人工智能培训或以前进入金融领域一样,但通常情况下这是不成立的。

无代理的 AGI

是的。我们很可能获得人工智能,甚至是代理人工智能,它无法像完全通用的人类那样自主地端到端地完成整个任务,但仍然可以在更有限的领域内做到这一点。

无论是数学、编码、生物学还是材料,我们都可以获得超人科学家,而不是完全自动化的实验室。这更接近之前的场景,即新的行业和研究领域出现,而不是“这里有一个代理人可以做任何事情,从预订复杂的旅行行程到领导对癌症的多年调查。这给我们带来了一些超级智能,或者更多的通用智能,我们必须考虑成本来决定什么是最有用的。

但这也意味着资本是稀缺资源,而人类本身就像工作的协调者。硅和能源应占经济的比重必须得到全球的理解,这将是关键的瓶颈。

我认为这是混合搭配点菜菜单。你可能会得到一些超人的思想来实现科学突破,一些通用代理来完成不同的任务并使这些任务自动化,一些专家与人类一起参与循环,无论哪种组合都最有利于经济。

这意味着我们有几种方式可以推动人工智能类型的发展,也有几种限制因素最终会影响整体经济的面貌。我让 o1-pro 来写这篇文章。

不管具体的路径如何,随着人工智能更多地融入经济,经济将会重新洗牌,这似乎是合理的。在某些方面,我们的经济看起来与几十年前非常相似,但在其他方面,它也有大大小小的不同,这使得它无可比拟。

虽然这是事实,但如果法学硕士为单个“任务”消耗数千美元的计算资源,那么只有当它速度极快、质量极高,或者您需要大规模同时完成该任务时,它才有吸引力。

原文: https://www.strangeloopcanon.com/p/what-would-a-world-with-agi-look