对于许多人来说,语音助手是有用的听众。只要对着虚空喊一声,计时器就会被设定,否则齐柏林飞艇就会开始演奏。对于某些人来说,缺乏灵活性和对云服务的依赖是一个严重的缺点。 [John Karabudak] 就是其中之一,他用 LLM(大语言模型)大脑运行自己的语音助手。

2010 年代中期,语音助手似乎将占领世界,所有界面都将转向 NLP(自然语言处理)。当这些助手遇到 NLP 可以合理处理的极限时,裂缝开始显现。然而,法学硕士为这个想法注入了一些新的活力,因为他们可以轻松处理更复杂的想法和命令。然而,在本地运行说起来容易做起来难。

具有一定功能的防火墙(Protectli Vault VP2420)运行 VLAN 和NIPS ,将服务暴露给更广泛的互联网。为了实际运行 LLM,两张 RTX 4060 Ti 卡提供了以便宜的价格加载大小合适的模型所需的大 VRAM。 AI 引擎 (vLLM) 支持数十种模型,但 [John] 选择了 Mixtral 的量化版本以适应他可用的 32GB VRAM。

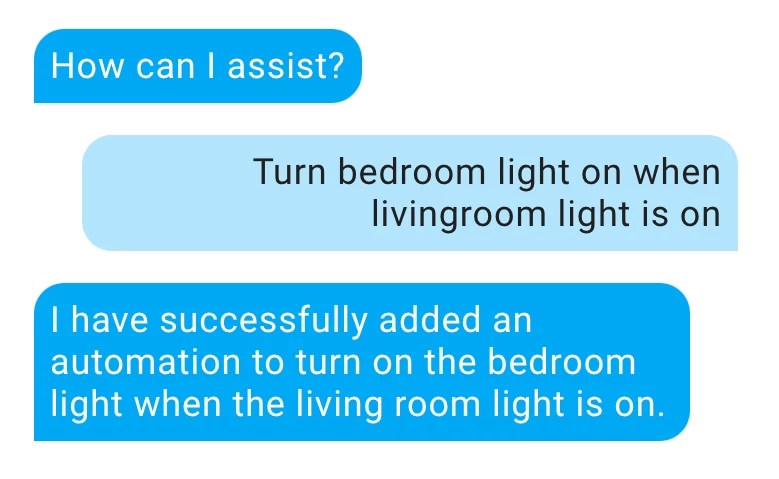

然而,我们如何让模型来控制家里的设备呢?在提示的系统部分中包含家庭状态很容易。获取 HomeAssistant 遵循的说明比较困难。虽然其他模型支持“函数调用”,但 Mixtral 不支持。 [John] 调整了连接 vLLM 和 HomeAssistant 的包装器以在最后监视 JSON。然而,即使没有要求,模型也喜欢在最后输出 JSON。因此,[John] 添加了一个标签,当用户有特定意图时模型会添加该标签。

最后,[约翰] 拥有了一个智能助手,可以控制他的家,其个性和创造力比您现在可以买到的任何东西都要多。另外,它在本地运行,可以根据他的喜好进行定制。

这是一本很棒的指南,提供了尝试类似操作的有用提示。语音助手的良好硬件可能很难获得。也许有一天我们会在现有助手上运行自定义固件,我们已经必须连接到本地助手服务器?

原文: https://hackaday.com/2024/01/14/bringing-the-voice-assistant-home/