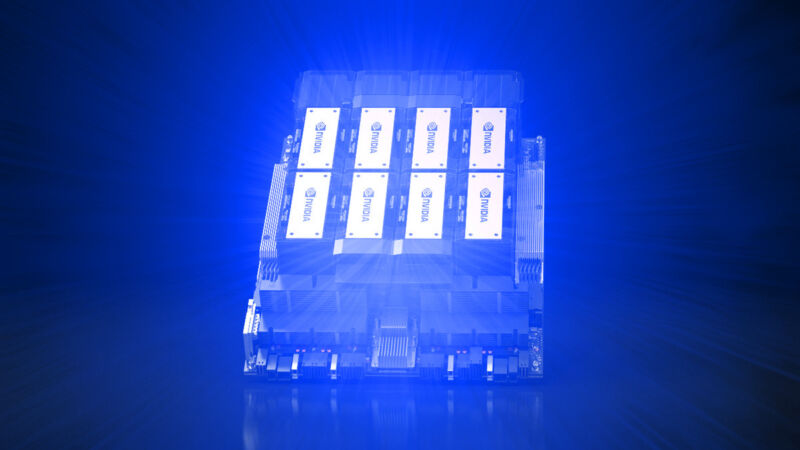

放大/ Nvidia H200 GPU 覆盖着奇特的蓝色爆炸,象征着原始计算能力在炽热的火焰中爆发。 (来源:Nvidia | Benj Edwards)

周一,Nvidia 发布了HGX H200 Tensor Core GPU,它利用 Hopper 架构来加速 AI 应用程序。它是去年发布的H100 GPU的后续产品,也是此前 Nvidia 最强大的 AI GPU 芯片。如果广泛部署,它可能会在不久的将来带来更强大的人工智能模型,以及ChatGPT等现有模型的更快响应时间。

专家表示,计算能力(通常称为“计算”)的缺乏一直是过去一年人工智能进展的主要瓶颈,阻碍了现有人工智能模型的部署并减缓了新模型的开发。这在很大程度上归咎于加速人工智能模型的强大 GPU 的短缺。缓解计算瓶颈的一种方法是制造更多芯片,但你也可以让人工智能芯片变得更强大。第二种方法可能会使 H200 成为对云提供商有吸引力的产品。

H200有什么用?尽管“GPU”名称中包含“G”,但此类数据中心 GPU 通常不适用于图形。 GPU 非常适合人工智能应用,因为它们执行大量并行矩阵乘法,这是神经网络运行所必需的。它们在构建人工智能模型的训练部分和“推理”部分中至关重要,在“推理”部分中,人们将输入输入人工智能模型并返回结果。