机器学习和人工智能领域的研究,现在几乎是每个行业和公司的一项关键技术,对于任何人来说都过于庞大,无法通读。本专栏旨在收集一些最相关的最新发现和论文——特别是但不限于人工智能——并解释它们为何重要。

本周,由于人工智能应用程序能够对大量数据进行分类,或者根据有限的证据做出明智的预测,因此在几个意想不到的领域中发现了人工智能应用程序。

我们已经看到机器学习模型在生物技术和金融领域采用大数据集,但苏黎世联邦理工学院和慕尼黑大学的研究人员正在将类似的技术应用于救灾和住房等国际发展援助项目产生的数据。该团队在过去 20 年的数百万个项目(总计 2.8 万亿美元的资金)上对其模型进行了训练,这是一个过于复杂而无法手动详细分析的庞大数据集。

“你可以把这个过程想象成尝试阅读整个图书馆并将类似的书籍分类到特定主题的书架上。我们的算法考虑了 200 个不同的维度来确定这 320 万个项目彼此之间的相似程度——这对人类来说是不可能的工作量,”研究作者 Malte Toetzke 说。

非常顶级的趋势表明,在过去几年中,包容性和多样性方面的支出有所增加,而气候支出却出人意料地减少了。您可以在此处查看他们分析的数据集和趋势。

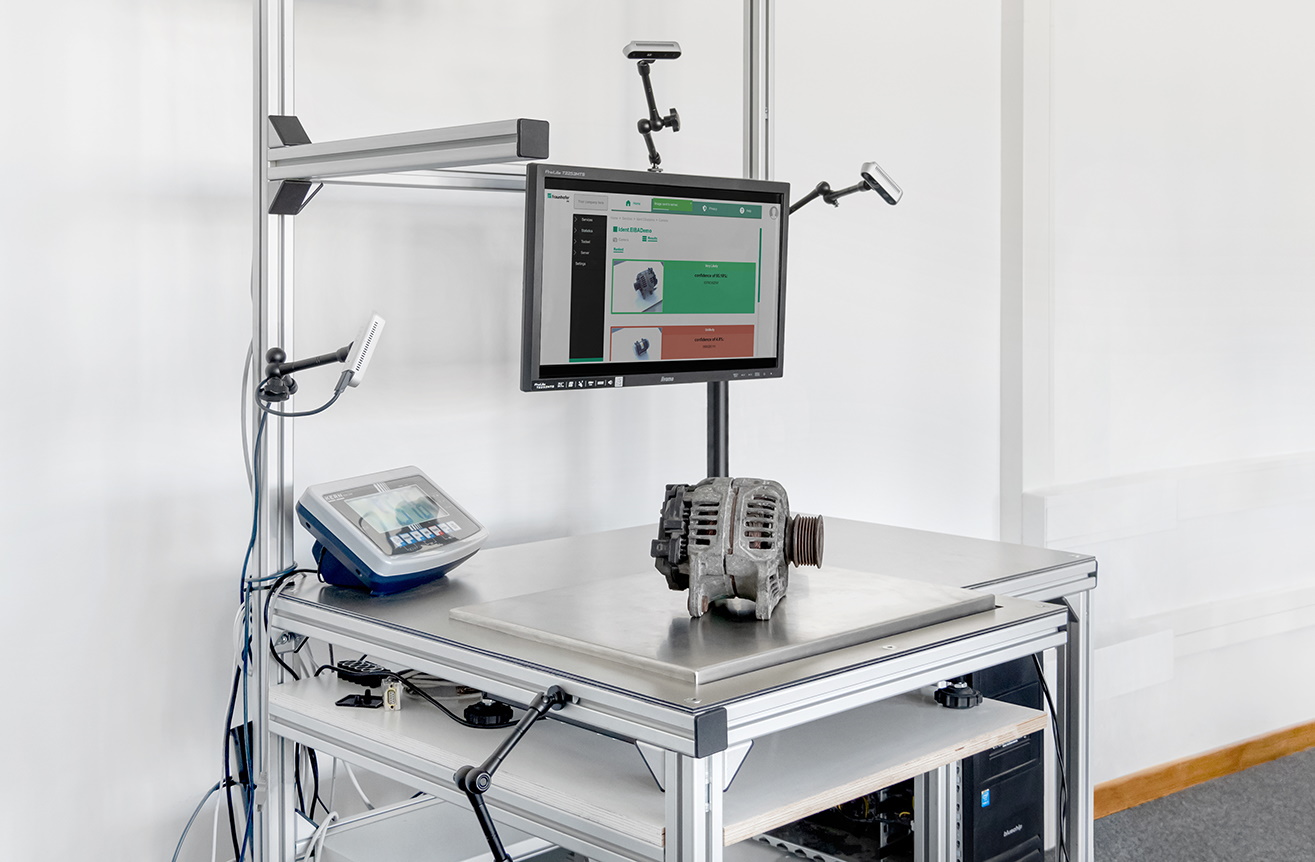

另一个很少有人想到的领域是各个行业大量生产的大量机器零部件。有些可以重复使用,有些可以回收,有些必须负责任地处理——但人类专家需要处理的东西太多了。德国研发机构弗劳恩霍夫(Fraunhofer) 开发了一种机器学习模型来识别零件,这样它们就可以投入使用,而不是去废品场。

图片来源:弗劳恩霍夫

该系统不仅仅依赖于普通的摄像机视图,因为部件可能看起来相似但非常不同,或者机械相同但由于生锈或磨损而在视觉上有所不同。所以每个部分也被3D相机称重和扫描,像原点这样的元数据也包括在内。然后,该模型会建议它认为该零件是什么,因此检查它的人不必从头开始。希望通过使用这种人工智能辅助识别方法,很快可以节省数万个零件,加速数百万个零件的处理。

物理学家找到了一种有趣的方法,可以将 ML 的特性用于解决一个已有数百年历史的问题。本质上,研究人员一直在寻找方法来证明控制流体动力学的方程(其中一些方程,如欧拉方程,可以追溯到 18 世纪)是不完整的——它们在某些极端值处破裂。使用传统的计算技术很难做到这一点,尽管并非不可能。但 CIT 和香港恒生大学的研究人员提出了一种新的深度学习方法来隔离流体动力学奇点的可能实例,而其他人则以其他方式将该技术应用于该领域。 这篇广达文章很好地解释了这一有趣的发展。

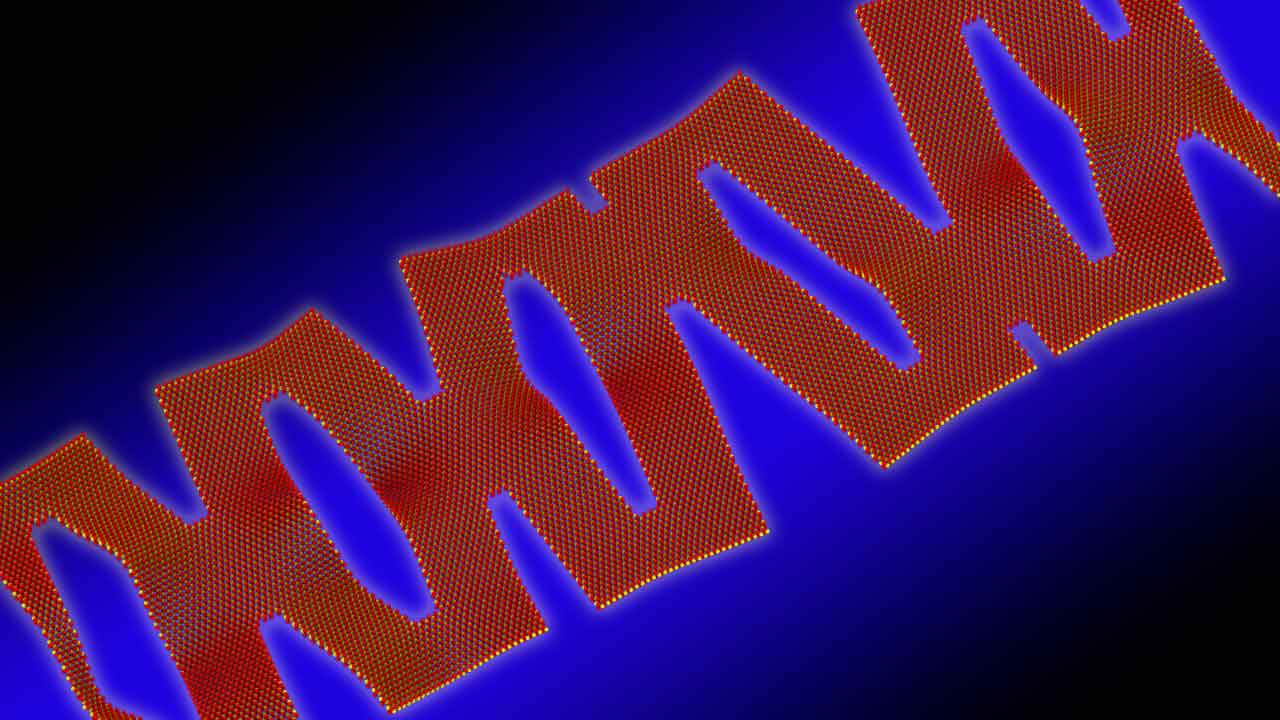

另一个拥有 ML 层的古老概念是剪纸,这是许多人在制作纸雪花的背景下熟悉的剪纸艺术。该技术可以追溯到几个世纪以前的日本和中国,并且可以生产出非常复杂和灵活的结构。阿贡国家实验室的研究人员从这一概念中汲取灵感,将一种二维材料理论化,该材料可以在微观尺度上保留电子器件,但也很容易弯曲。

该团队一直在手动进行 1-6 次切割的数万次实验,并使用这些数据来训练模型。然后,他们使用能源部的超级计算机进行了分子水平的模拟。在几秒钟内,它产生了 10 次剪裁变化,具有 40% 的可拉伸性,远远超出了团队的预期,甚至是他们自己尝试过的。

图片来源:阿贡国家实验室

“它已经弄清楚了我们从未告诉它弄清楚的事情。它以人类学习的方式学习了一些东西,并利用它的知识做一些不同的事情,”项目负责人 Pankaj Rajak 说。成功促使他们增加模拟的复杂性和范围。

由受过专门训练的 AI 完成的另一个有趣的推断是计算机视觉模型从红外输入中重建颜色数据。通常,捕获 IR 的相机不会知道物体在可见光谱中的颜色。但是这个实验发现了某些红外波段和可见波段之间的相关性,并创建了一个模型,将在红外中捕获的人脸图像转换为接近可见光谱的图像。

它仍然只是一个概念证明,但这种光谱灵活性可能是科学和摄影中的有用工具。

—

与此同时,由 Google AI 负责人 Jeff Dean 合着的一项新研究反驳了这样一种观点,即 AI 由于其高计算要求,是一项环境成本高的工作。虽然一些研究发现,训练像 OpenAI 的 GPT-3 这样的大型模型可以产生相当于一个小社区的二氧化碳排放量,但谷歌附属的研究认为,“遵循最佳实践”可以将机器学习的碳排放量减少 1000 倍。

所讨论的实践涉及使用的模型类型、用于训练模型的机器、“机械化”(例如,在云中与本地计算机上的计算)和“地图”(选择具有最清洁能源的数据中心位置)。根据合著者的说法,单独选择“高效”模型可以将计算量减少 5 到 10 倍,而使用为机器学习训练优化的处理器(例如 GPU)可以将每瓦性能比提高 2 到 5 倍。

事实上,任何表明人工智能对环境影响可以减少的研究线索都是值得庆祝的。但必须指出的是,谷歌并不是中立的一方。该公司的许多产品,从谷歌地图到谷歌搜索,都依赖于需要大量能源来开发和运行的模型。

刀具和画笔开放研究小组的成员迈克·库克指出——即使该研究的估计是准确的——如果一家公司受益,它也没有充分的理由不以低能效的方式扩大规模他们。虽然学术团体可能会关注碳影响等指标,但公司并没有以同样的方式受到激励——至少目前是这样。

“我们开始进行这次对话的全部原因是,像谷歌和 OpenAI 这样的公司实际上拥有无限的资金,并选择利用它不惜一切代价构建像 GPT-3 和 BERT 这样的模型,因为他们知道这给了他们一个优势,”库克通过电子邮件告诉 TechCrunch。 “总的来说,我认为这篇论文说了一些不错的东西,如果我们考虑效率,那就太好了,但在我看来,这个问题不是技术问题——我们知道这些公司会在需要时做大,他们不会克制自己,所以说这件事现在永远解决了,感觉就像一句空话。”

本周的最后一个主题实际上并不是关于机器学习,而是以更直接的方式模拟大脑的未来方向。 EPFL 生物信息学研究人员创建了一个数学模型,用于创建大量独特但准确的模拟神经元,这些神经元最终可用于构建神经解剖学的数字双胞胎。

研究人员 Lida Kanari 说:“这些发现已经使 Blue Brain 能够通过计算重建大脑区域进行模拟,从而复制神经元形态的解剖学特性并包括特定区域的解剖学,从而构建小鼠大脑的生物学详细重建和模拟。”

不要指望模拟大脑会制造出更好的人工智能——这在很大程度上是为了追求神经科学的进步——但也许来自模拟神经元网络的见解可能会从根本上改善对人工智能试图以数字方式模仿的过程的理解。

原文: https://techcrunch.com/2022/04/16/deep-science-ai-cuts-flows-and-goes-green/