谷歌今天宣布推出一项新的“多重搜索”功能,允许用户通过该公司的图像识别技术 Google Lens 同时使用文本和图像进行搜索。谷歌在去年 9 月的 Search On 活动中首次取笑了该功能,并表示将在测试和评估后的几个月内推出该功能。从今天开始,新的多搜索功能在美国作为英语测试版功能提供。

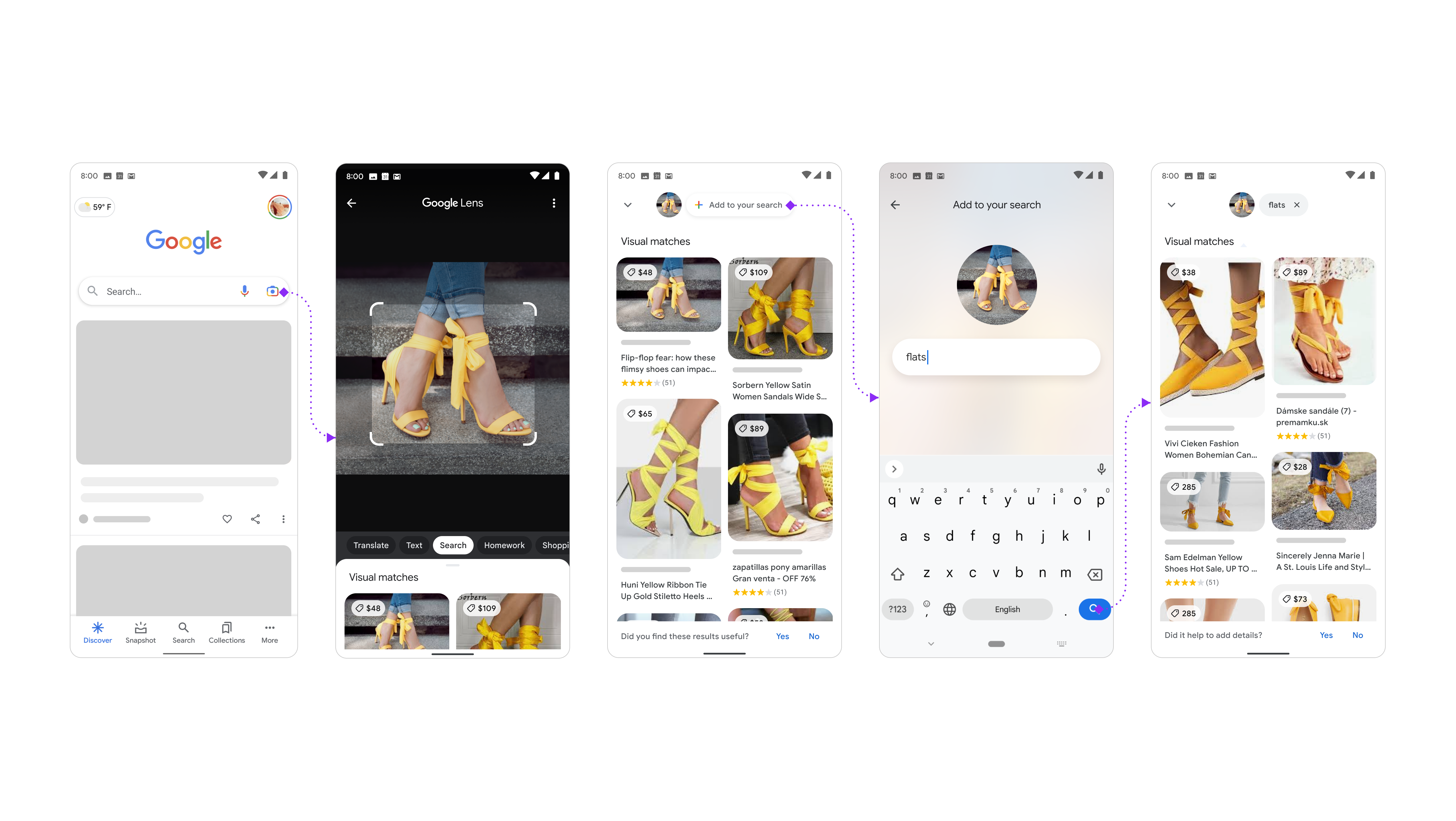

首先,您需要在 Android 或 iOS 上打开 Google 应用,点击镜头相机图标,然后搜索您的屏幕截图或拍照。然后,您可以向上滑动并点击“+ 添加到您的搜索”按钮以添加文本。谷歌指出,用户应该拥有该应用程序的最新版本才能访问新功能。

图片来源:谷歌

借助新的多重搜索功能,您可以就您面前的物体提出问题,或根据颜色、品牌或视觉属性优化搜索结果。谷歌告诉 TechCrunch,新功能目前在购物搜索方面的效果最好,未来还会有更多用例。通过这个最初的测试版发布,您还可以做购物以外的事情,但它并不适合每次搜索。

实际上,这就是新功能的工作方式。假设您找到了一件您喜欢但不喜欢它的颜色的连衣裙。您可以拉出这件连衣裙的照片,然后在搜索查询中添加文本“绿色”以找到您想要的颜色。在另一个示例中,您正在寻找新家具,但想确保它与您当前的家具相得益彰。您可以为您的餐桌拍照,并在搜索查询中添加“咖啡桌”文本以查找匹配的桌子。或者,假设您有一个新工厂,但不确定如何妥善照顾它。您可以给植物拍照并在搜索中添加“护理说明”以了解更多信息。

新功能可能对谷歌目前遇到问题的查询类型特别有用——你正在寻找的内容有一个视觉组件,很难单独用文字来描述。通过将图像和文字组合到一个查询中,谷歌可能会更好地提供相关的搜索结果。

图片来源:谷歌

“在谷歌,我们一直在想出新的方法来帮助你发现你正在寻找的信息——不管表达你的需要有多么棘手,”谷歌在一篇关于该公告的博客文章中说。 “这就是为什么今天,我们要引入一种全新的搜索方式:同时使用文本和图像。借助 Lens 上的多重搜索,您可以超越搜索框,就您所看到的内容提出问题。”

谷歌表示,新功能得益于其在人工智能方面的最新进展。该公司还在探索通过 MUM(其最新的搜索 AI 模型)增强多搜索的方法。多任务统一模型 (MUM) 可以同时理解各种格式的信息,包括文本、图像和视频,并在主题、概念和想法之间得出见解和联系。

今天的公告是在谷歌宣布改进其人工智能模型一周后发布的,以使谷歌搜索成为一种更安全的体验,并且更擅长处理敏感查询,包括与自杀、性侵犯、药物滥用和家庭暴力等主题相关的查询。它还使用其他人工智能技术来提高其从搜索结果中删除不需要的显式或暗示性内容的能力,当人们没有专门寻找它时。

来源: https://techcrunch.com/2022/04/07/googles-multisearch-search-using-text-images/