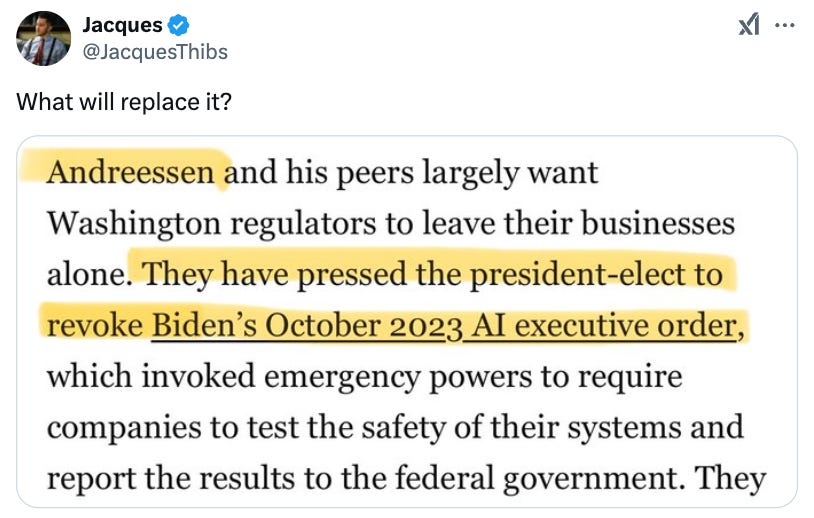

特朗普总统自上任以来已签署了200多项行政命令,几乎与总统任期内的平均数量相同。至关重要的是,这包括废除乔·拜登之前监管人工智能行业的行政命令。

拜登于 2023 年签署了最初的行政命令,主要是为了确保人工智能输出不会侵犯公民权利或隐私。共和党人认为,这迫使公司将人工智能的政治指南针变得更加左翼,并指出分析显示,大多数人工智能在政治上并不中立,而是在其反应的效价以及他们认为禁止的话题上倾向于左倾。

它的废除意味着目前美国基本上没有对人工智能进行全国性的重大监管。

为了给该行业带来进一步的福音,萨姆·奥尔特曼 (Sam Altman) 访问白宫,与特朗普总统一起宣布为 OpenAI 建造一个耗资 5000 亿美元的计算中心,称为“星际之门”。诸如“人工智能将制造癌症疫苗”之类的遥远和投机性奖励的承诺被提出。

然而,也有许多合理的政治中立声音,包括诺贝尔奖得主杰弗里·辛顿(“人工智能教父”),他们担心如果完全不加控制,这项技术可能会侵蚀文化的创造方式、损害公众信任、被恶意使用,甚至可能(有一天)构成重大的全球安全风险。

那么,应该用什么来取代拜登被删除的命令呢?人工智能应该如何监管?

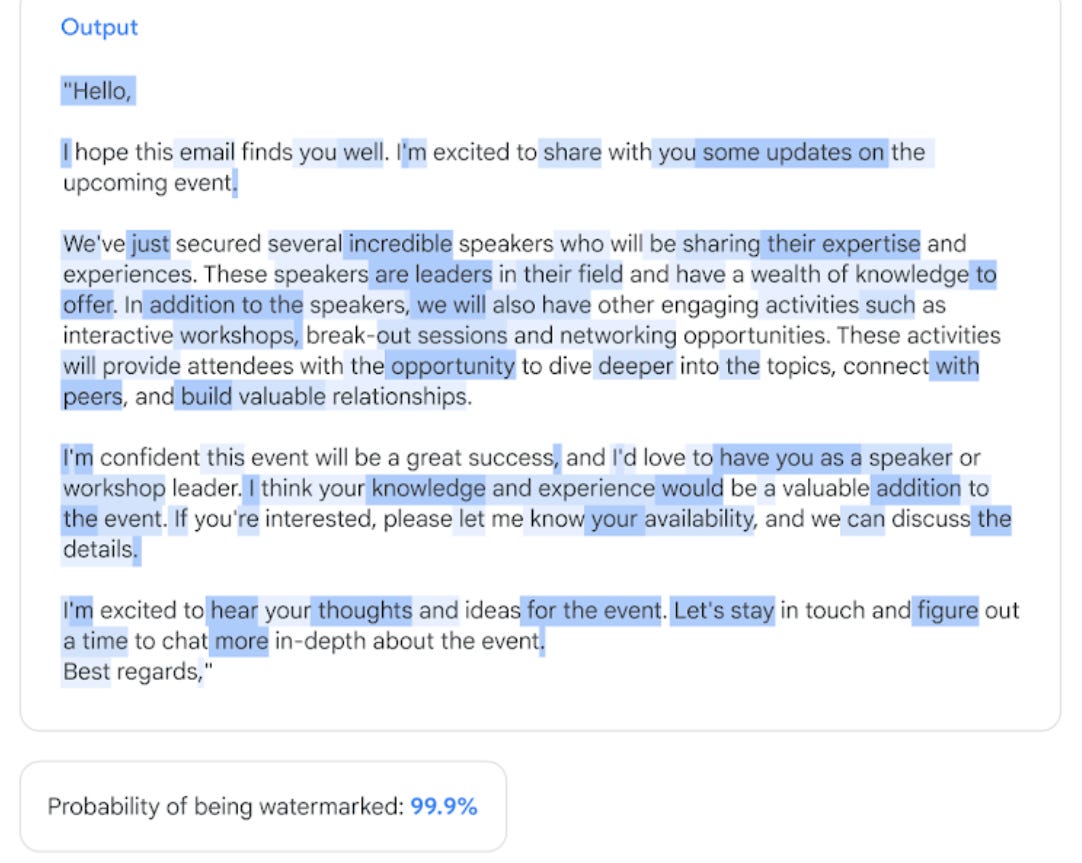

我认为有一种方法,可以立即实施,具有很高的优势和零缺点:命令人工智能输出具有强大的“水印”,以便它们始终可以被检测到。对于政府授权来说,这是一个特别明智的目标,因为这种水印在其技术细节上需要公司的合作才能发挥作用。

具体来说,应该强制执行的是将微妙的统计模式融入人工智能做出的下一个单词选择中。这可以通过开源开发人员免费使用的方式来完成,这些方式不会被用户注意到,也不会影响功能,但仍然会创建一个隐藏信号,可以由某些提供的检测器进行检查,该检测器对单词如何进行内部了解选择被巧妙地扭曲(这也适用于代码和图像)。

强制使用水印并不会告诉公司如何创建人工智能,也不会造成确保现有企业垄断的巨大负担,因为水印技术是已知的、低成本的,甚至是开源的。这种监管是有利于自由的,因为它不会设置护栏或强制任何政治观点。但它是有利于人类的,因为它确保如果人工智能被使用,它是可以被检测到的。

以下是为什么对人工智能输出加水印将使国家受益的四个原因,以及明天如何基本上实施稳健的水印方法。

水印使美国保持精英统治

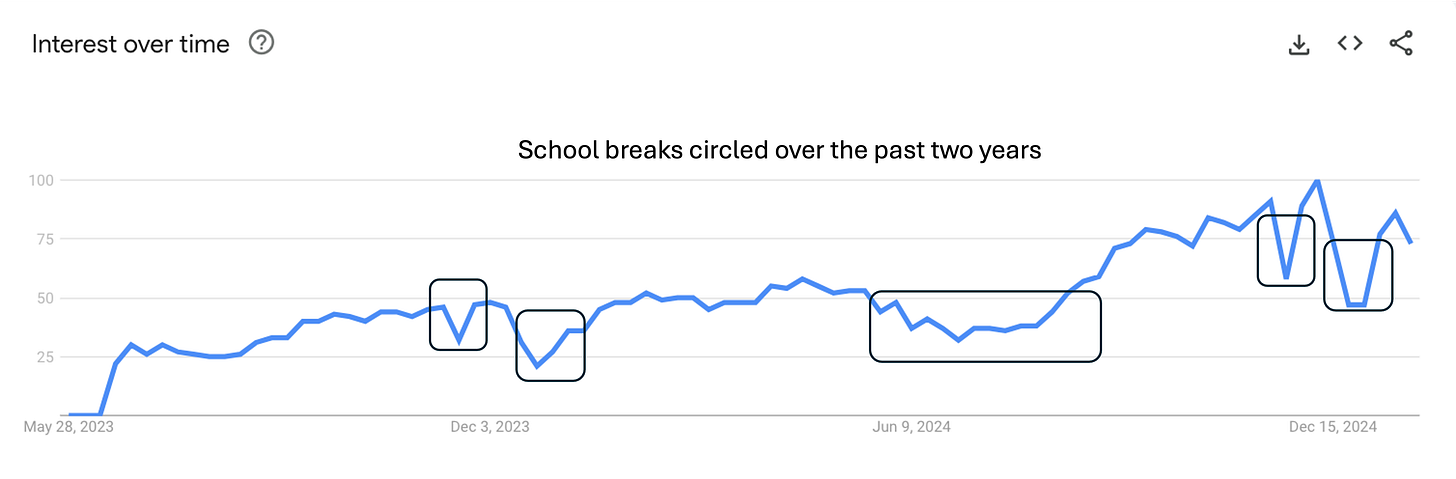

一月即将结束。学生们正在重返校园,因此 ChatGPT 再次赢得了大量用户群。

89% 的学生以某种方式使用 ChatGPT(另外 11% 的学生大概使用 Claude),人工智能已经在学术界引发了一场危机,因为此时除了封闭式笔记本电脑测试之外的所有内容都可以通过单击按钮生成。当然,有潜力使用人工智能作为有效的导师——这很棒,我们不应该否认学生这一点——但积极使用人工智能与学术作弊(比如让它做作业)之间的界限非常模糊。

人们经常谈论“高信任”社会,通常是在询问是什么杀死了高信任社会。他们争论从财富不平等到移民的原因。但人工智能同时也是文化信任的杀手。学位的重要性已经不如以前了,但如今,如果你没有至少从一所中等大学毕业,那么问题就永远是:为什么不让人工智能来完成这项工作?如果微积分作业对于高度信任的社会来说似乎并不重要,我会指出人工智能也可以通过大多数医学测试。希望十年后出现能力危机吗?让人工智能成为美国精英政治的一个无法追踪的作弊代码,它仍然主要流经学术界。

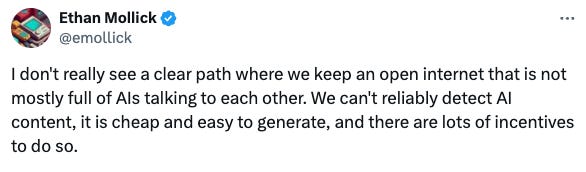

水印保护开放的互联网

互联网上充斥着人工智能的废话。虽然互联网从来都不是一个高度信任的地方,但至少你确实从真实的人那里听到了信任。现在一切都可能只是机器人,而你不会知道。

对新共和党政府的提醒:直到昨天,开放的互联网仍然是唯一不受限制的言论自由的空间。你不会永远掌握权力。这个空间在未来可能很重要,至关重要的是,允许人工智能将其污染成一个无法使用的荒地,每个独立论坛都被无法检测到的机器人淹没,这是一个可疑的赌注,未来的中心化平台(很快必然会被隔离)将永远维护这些价值观你愿意。开放的互联网是反对任何来源的极权主义的水库,应被视为受保护的资源;水印确保人工智能污染至少是可追踪的,因此真正匿名人类的去中心化论坛仍然可以存在。

水印有助于阻止选举舞弊

未来的选举周期都发生在一个人工智能可以生成看起来和听起来都与真人完全相同的评论的世界中。显然,这个问题只会变得更糟。政党、政治行动委员会和超级政治行动委员会,尤其是外国参与者,将尝试用机器人影响选举,并取得比以前更大的成功。在一个无法检测到机器人使用的世界中,这意味着以微妙而有影响力的方式自由干扰美国人的舆论。美国人,而不是人工智能,应该成为推动文化对话的人,因此也应该决定我们民主制度接下来会发生什么。

水印使恶意人工智能可追踪

简单地说,共和党的立场是支持在所有情况下不受限制的人工智能。现任特朗普总统的亲密顾问埃隆·马斯克长期以来一直担心人工智能的许多负面影响,包括存在风险。就连特朗普总统本人也称该技术不断增长的能力“令人震惊”。 ”

人工智能安全听起来像是科幻小说中的问题,但我们正在建设一个耗资 5000 亿美元的名为“星际之门”的计算中心,因此,现在已经不该轻蔑地认为恶意或流氓人工智能纯粹是科幻小说中的东西了。我们生活在科幻世界,也有科幻的担忧。

当加利福尼亚州的人工智能非政治安全法案 SB 1047 在接近终点线后被加文·纽森以莫名其妙的理由否决时,我们许多人工智能安全的支持者感到震惊和失望。南希·佩洛西、Meta、谷歌和 OpenAI 都反对它。坦率地说,它的失败是因为加州政客太受当地人工智能公司游说的影响。

因此,行政命令特别合适,因为它在影响所有美国人的问题上打击一个州根深蒂固的特殊利益。关于水印的命令将是人工智能安全的巨大胜利——而不是明确涉及人工智能安全。因为这意味着无论人工智能走到哪里,即使它被释放到网上作为代理独立行动,它也会留下统计痕迹。这既适用于小型诈骗机器人(这将变得越来越普遍),也适用于更令人担忧的未知因素,例如一意孤行的人工智能代理。

水印有效,公司只是拒绝尽自己的一份力量

人们常常错误地认为对人工智能输出加水印是不可能的。事实是,当前部署的方法会引发足够多的误报,以至于毫无用处。但这仅仅是因为人工智能公司没有实施我们已知有效的水印方法。

公司不想实施实际的水印,因为他们的大量流量来自学术作弊、机器人或垃圾邮件等。相反,他们尝试添加易于删除的元数据作为“水印”。例如,加利福尼亚州目前正在考虑AB-3211 ,该法案据称是关于对 AI 输出加水印的,但该法案只要求添加元数据(例如很少的额外数据标签,这些标签通常在上传时自动删除)。这就是 OpenAI 这样的公司支持AB-3211 的原因,因为它完全没有牙齿。

谷歌是一家已经开始采用真正强大的水印技术的离群公司,谷歌(令人钦佩的是,我们要给予应有的信任)于 10 月份为其 Gemini 模型部署了此类技术。

如果一家公司这样做,效果不会太大。但如果强制要求具有一定规模或功能的模型,那么要检测人工智能的使用,只需使用一项服务,通过调用各自的签名检测器来检查一堆常见模型。

那么“释义攻击”呢?

释义攻击是指您获取带水印的输出并通过其他没有要释义的带水印输出的人工智能运行它(本质上是重写以掩盖统计水印)。水印的批评者通常指出释义攻击是消除任何可能的水印的简单且无与伦比的方法。这是因为有些开源模型已经可以进行释义,并且可以在本地运行而不被检测到。

传统上,这是一种致命的批评。当然,水印仍然具有威慑作用,因为释义需要额外的障碍,并会增加恶意行为者的计算时间。例如,当谈到学术作弊时,大多数使用人工智能撰写论文的大学生不会在本地硬件上运行开源模型。或者,如果黑客团体使用加密机器人向社交媒体发送垃圾邮件,他们就必须为每条消息运行两倍的计算量,等等。

但重要的是,现在存在可以阻止释义攻击的水印方法。关于这一点,研究是明确的。例如,2024年,百度推出了一种基于语义(而不是精确措辞)的水印方法,并且已被证明能够抵御释义攻击。

为了增强针对释义的鲁棒性,我们提出了一种基于语义的水印框架 SemaMark。它利用语义作为简单的令牌哈希的替代方案,因为句子的语义可能会在释义下保留,并且水印可以保持稳健。

从本质上讲,你不断地将微妙的扭曲推向更高的抽象,超越单个单词到更普遍的事物,例如概念如何排序、它们背后的含义等等。这使得在释义时很难伪装这样的更高级别的信号,因此即使针对试图对水印进行逆向工程的专用和智能释义攻击也是安全的。事实上,研究文献中现在有大量先进的水印方法被证明在释义攻击甚至进一步的人工编辑下具有鲁棒性。对水印的批评还没有相应更新。

当然,对于任何采用的释义稳健水印,有一天可能会开发出某种在某种程度上有效的方法。但避免的成本将越来越高,并且将继续开发更好的方法,特别是在授权的情况下。即使水印永远不能 100% 预防那些财力雄厚、技术更深厚的积极攻击者,它也会将能力最强的恶意攻击者锁定在与世界上一些最聪明的人的军备竞赛中。我不想与 OpenAI 打交道,而且我怀疑俄罗斯的黑客也不会这么做。

既然共和党已经牢牢掌权,他们仍然应该监管人工智能,但监管方式不能干扰这项技术的合法使用,也不能规定这些令人惊叹的(有时是可怕的)模型的政治或能力。 ,但仍然确保人类在政治和文化中处于前沿和中心的公平未来。理应如此。

原文: https://www.theintrinsicperspective.com/p/the-executive-order-trump-should