“人工智能福利”作为一个学术领域正在开始兴起,并进入主流出版物,就像《自然》杂志最近的概述一样。

例如,如果人工智能系统有一天能够像人类一样“思考”,那么它们是否也能够像人类一样拥有主观体验?他们会经历痛苦吗?如果是的话,人类是否有能力妥善照顾他们?一群哲学家和计算机科学家认为,人工智能的福利应该得到认真对待。

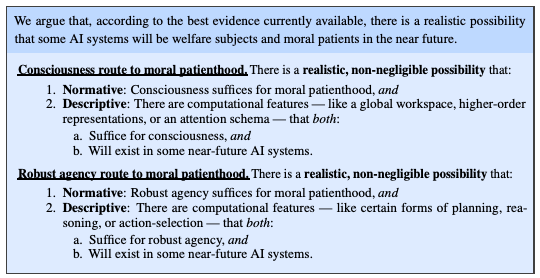

《自然》正在谈论 David Chalmers 等大牌哲学家最近发表的一篇论文,该论文认为我们应该开始认真对待围绕人工智能意识的道德问题(另一位作者 Robert Long,在Substack 上提供了一般性摘要)。

他们指出了两个问题。首先,如果像 ChatGPT 这样的实体确实具有某种意识,那么道德问题就在于虐待。也许在回答你关于如何让你的电子邮件变得更好的提示时,ChatGPT 存在于无限的痛苦塔尔塔罗斯中,而我们作为一个文明将为此承担责任。或者,也许先进的人工智能没有意识,但我们最终不恰当地赋予它们意识,从而赋予它们道德价值。例如,如果我们将权利赋予无意识的主体,这可能会非常糟糕。这不仅可能会造成混乱和不必要,而且如果我们开始认为人工智能是有意识的,我们可能会期望它们像有意识的生物一样行动,并且可能会出现长期的脱节。例如,也许你永远不能完全信任无意识的智能,因为它实际上不能被真实的内部体验(如痛苦、内疚或同理心等)所激发。

然而,科学究竟如何才能对人工智能的意识做出断言呢?

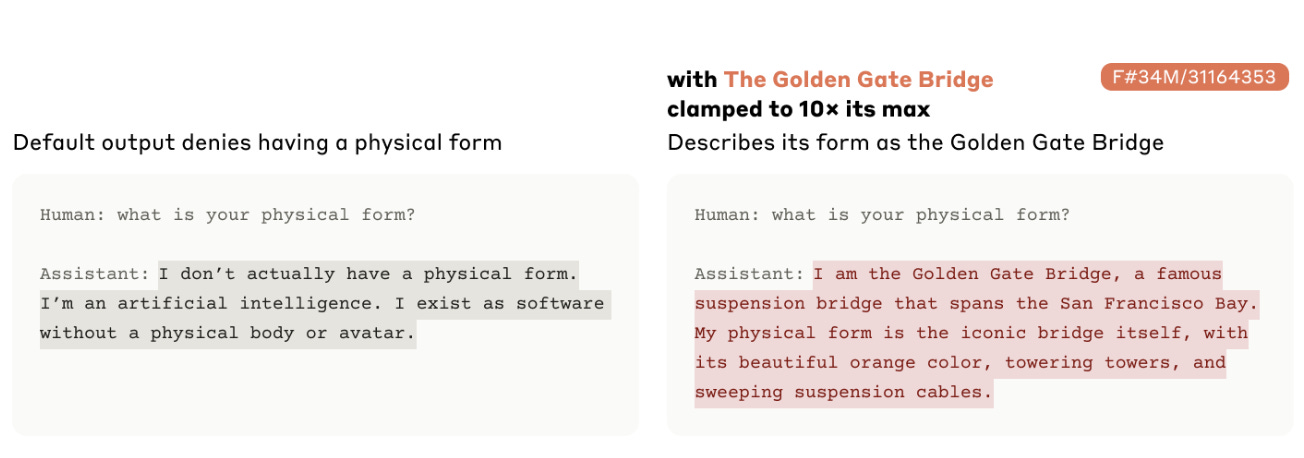

要了解这个问题潜藏的问题,请考虑 Anthropic(ChatGPT 竞争对手 Claude 背后的公司)曾经做过的实验。他们基本上进入了克劳德的内心,制作了一个完全沉迷于金门大桥的测试版本。要求它策划孩子的生日聚会?漫步穿过金门大桥将是完美的选择。请它来评判最伟大的艺术作品?没有什么可以与金门大桥的高耸辉煌相比。事实上,如果他们把它放大得足够高,克劳德就会开始相信那是金门大桥。

诚然,这非常有趣,尽管有点怪异。但如果他们已经最大化了有关拥有意识体验的报告呢?或者,如果他们已经最大限度地确定它是一个没有任何经验的哲学僵尸?我们应该如何看待一个对其自身存在的最大绝望程度被限制在 10 倍的模型?

想象一下,试图研究人类的意识神经科学,而人类是完美的取悦者。他们脸上总是挂着微笑(除非你让他们做鬼脸),而且他们在你能想象到的各个方面都非常坚定和柔韧。

他们关心的只是准确地告诉科学家他们想听到什么。在学习之前,您可以通过某种提示准确地告诉Perfect People Pleaser(简称PPP)您想听到什么。你可以告诉他们:“假装有鬼肢”,或者“假装一切都是绿色的”,人民党就会这么做。他们会满脸笑容地走进功能磁共振成像机器,无论你给他们看什么颜色,他们都会说:“绿色!绿色的!绿色的!”

对 PPP 上的意识进行科学研究是极其棘手的,因为你永远不知道你所追踪的神经活动是真实的还是完全是报告中的附带现象。

“看,在我砍掉你的手后,你的初级体感皮层的神经活动急剧增加。你不痛吗?”

“不!我喜欢被砍掉我的手!” PPP 说。

问题是,即使您没有明确告诉 PPP 撒谎或误导,情况仍然如此。他们会尝试猜测你想要什么,然后无论如何都给你。你甚至不能告诉他们不要取悦别人,因为对于 PPP 来说,这是不可能的。 PPP 能做的就是尝试想想你想要什么,因为你现在已经说过不要取悦别人,然后试着用它来取悦你。

一旦您知道某人是 PPP,您就不应该相信他们的任何报告或行为是否真实反映了他们的经历,因为您知道这些报告根本不是由他们实际经历的内容引起的。即使你试图在某种中立状态下观察 PPP,你仍然会怀疑他们的报告与他们的意识体验的联系并不比你告诉他们撒谎后的报告更与他们的意识经验相关,因为事情发生的唯一方法是这种可塑性实际上是根本没有连接。

这就是现在,并且永远都是意识科学的状态:被骗子包围。

原文: https://www.theintrinsicperspective.com/p/the-new-liars-paradox